Criminele relevantie LLM's

Criminelen worden op allerlei manieren gefaciliteerd door LLM's, maar ze vormen ook een doel

LLM's als kennisbron

ChatGPT excelleert in het verschaffen van kant-en-klare informatie aan de gebruiker in reactie op een breed scala aan vragen (prompts). Daardoor kan ChatGPT worden gebruikt om te leren over een groot aantal potentiële criminele gebieden zonder voorafgaande kennis, variërend van tips om in te stelen en het maken van explosieven[1] tot cybercrime en kindermisbruik. Door zowel Europol[2] als Interpol[3] zijn een groot aantal gebruiksscenario’s geïdentificeerd.

Ook extremisten kunnen er terecht voor tips, zo deelde een gebruiker op een ISIS-platform het antwoord dat hij van ChatGPT kreeg toen hij vroeg hoe hij het beste het kalifaat kon steunen; "he shared the full ChatGPT reply to his questions, which included detailed steps for identifying and mobilizing a "core group of supporters," developing a "political program and ideology," gaining support from "the Muslim community," taking "control of territory," establishing "institutions and government structures," and promoting and defending the new caliphate..."[4]

De aanbieders van LLM’s reageren hierop door contentfilters toe te voegen waardoor je niet direct kunt vragen naar dergelijke informatie. Tot op heden weten mensen daartoe echter nog steeds workarounds te vinden, bijvoorbeeld door ernaar te vragen in de vorm van een filmscript of scenario. Ook worden er modellen gedeeld die juist bedoeld zijn criminelen te helpen en is het mogelijk die beperkingen uit te schakelen op modellen die je zelf installeert.

LLM’s als doel & middel

In de paragraaf over desinformatie werd al beschreven dat LLM’s kwetsbaar zijn voor cyberattacks waarmee bijvoorbeeld de antwoorden die het systeem geeft gemanipuleerd kunnen worden (data poisoning). Inmiddels is het laagste tarief voor het op deze manier aantasten van de integriteit van data (en werking systemen) 60 dollar[1].

Het Amerikaanse National Institute of Standards and Technology (NIST) publiceerde begin 2024[2] haar onderzoek naar cyberattacks waarmee het gedrag van AI-systemen gemanipuleerd kan worden, de conclusies waren:

· “AI systems can malfunction when exposed to untrustworthy data, and attackers are exploiting this issue.

· New guidance documents the types of these attacks, along with mitigation approaches.

· No foolproof method exists as yet for protecting AI from misdirection, and AI developers and users should be wary of any who claim otherwise.”

Zo zijn er mogelijkheden om via de chatbots persoonlijke data te stelen[3]. Inmiddels zie je dat er ook gepoogd wordt bedrijven die LLM’s geïntegreerd hebben in klanttoepassingen, te hacken via zogeheten “prompt injections”. Het Engelse Cyber Security Center (NCSC) waarschuwt daarom bedrijven die overwegen diensten te bouwen op LLM’s dezelfde voorzorg te hebben als bij andere software die nog in beta is.[4]

“The publication emphasizes the absence of a foolproof defence mechanism against such adversarial attacks, urging developers and users to exercise caution amidst claims of impenetrable safeguards.”

Het gebruik van LLM’s vergroot ook de kans op lekken, bijvoorbeeld doordat mensen iets samenvatten met een online tool en zo mogelijk interne informatie naar buiten brengen of zo’n tool gebruiken om te ondersteunen bij programmeren en zo informatie over de IT systemen naar buiten brengen. Diverse organisaties hebben daarom het gebruik verboden.[5]

Dat criminaliteit laagdrempeliger wordt kan ertoe leiden dat er in Nederland meer mensen slachtoffer worden, vooral door de meertaligheid en het natuurlijk taalgebruik dat ook nog eens uitgesproken kan worden door betrouwbaar klinkende stemmen. Voor criminelen uit het buitenland wordt het daardoor veel laagdrempeliger om Nederlanders benadelen.

Criminelen gebruiken LLM’s inmiddels als middel bij het plegen van criminaliteit[6]. Zo wordt het al veel gebruikt in de context van oplichting en fraude[7]. Denk aan het genereren van phishing mails[8], social engineering[9], fake websites, fake profielen en fake reviews[10]. Het is nu mogelijk om volledig geautomatiseerd telefoontjes te plegen waarbij gelijktijdig honderden of duizenden mensen benaderd worden om hen te overtuigen tot de aankoop van iets, het delen van vertrouwelijke gegevens of andere handelingen die niet in hun eigen belang zijn[11]. Inmiddels worden LLM’s ook gebruikt voor het genereren[12] en verspreiden[13] van malware. Om bij deze vormen van criminaliteit te ondersteunen zijn er zelfs speciaal voor criminelen gemaakte LLM’s, zoals WormGPT[14] en FraudGPT[15].

Begin 2024 is er een studie[16] verschenen naar deze zogenaamde Malla’s (Malicious LLM applications) op basis van voorbeelden uit de echte wereld, waarbij ook gekeken is naar het underground ecosysteem en de implicaties voor cybersecurity. Voor een verdieping wordt naar het onderzoek verwezen, maar conclusie is dat het aanbod sterk groeit en dat een deel van de aangeboden tooling effectief is.

Our findings bring to light that certain Mallas, such as DarkGPT and EscapeGPT, excel in producing high-quality malware that is both compilable and capable of evading VirusTotal detection, while others (e.g., WolfGPT ) can create phishing emails with a high readability score and manages to bypass OOPSpam. Although Malla generally lags in crafting phishing sites, one Malla (EscapeGPT) distinguishes itself by generating operational phishing site codes that go unnoticed. This highlights the significant concerns surrounding the cybercriminal exploitation of LLMs.

Een andere ontwikkeling is dat avatars (variërend van realistische personages in 3D werelden tot een chatbot op social media) gekoppeld kunnen worden aan een LLM als ChatGPT, waardoor ze 24/7 aanwezig kunnen zijn in een bepaalde omgeving en volstrekt natuurlijke gesprekken kunnen voeren (waardoor die omgevingen opeens heel druk en actief lijken). Er wordt hier al een hoop mee geëxperimenteerd door doe-het-zelfers, maar inmiddels bied een belangrijke game-engine dit ook standaard aan als functionaliteit. Onderzoek laat zien dat je deze avatars via ChatGPT ook specifieke karaktereigenschappen en intenties (doelen) mee kunt geven[17]. Extremisten kunnen dit inzetten voor het uitdragen van een bepaalde boodschap, aanmoedigen tot acties (met bijvoorbeeld als beloning dat ze met Osama Bin Laden in gesprek mogen) of rekruteren van aanhangers.

[1] https://www.vice.com/en/article/xgyp9j/openais-new-chatbot-will-tell-you-how-to-shoplift-and-make-explosives

[2] https://www.europol.europa.eu/cms/sites/default/files/documents/Public%20Version%20-%20ChatGPT%20report.pdf

[3] file:///C:/Users/Acer/Downloads/ChatGPT-Impacts%20on%20Law%20Enorcement-%20August%202023.pdf

[4] https://www.newsweek.com/terrorists-love-new-technologies-what-will-they-do-ai-opinion-1787482

2e alinea:

[1] https://www.trendmicro.com/vinfo/us/security/research-and-analysis/predictions/critical-scalability-trend-micro-security-predictions-for-2024 & https://www.technologyreview.com/2023/10/23/1082189/data-poisoning-artists-fight-generative-ai/

[2] https://www.nist.gov/news-events/news/2024/01/nist-identifies-types-cyberattacks-manipulate-behavior-ai-systems

[3] Door de chatbot in te zetten als scammer https://www.vice.com/en/article/7kxzzz/hackers-bing-ai-scammer, maar ook door de chatbot de in de trainingsdata aanwezige persoonlijke data te laten onthullen. https://www.404media.co/google-researchers-attack-convinces-chatgpt-to-reveal-its-training-data/

[4] https://therecord.media/prompt-injection-uk-ncsc-artificial-intelligence-warning

[5] https://securityaffairs.com/143394/security/company-data-chatgpt-risks.html; https://www.bloomberg.com/news/articles/2023-05-02/samsung-bans-chatgpt-and-other-generative-ai-use-by-staff-after-leak; https://www.theverge.com/2023/5/19/23729619/apple-bans-chatgpt-openai-fears-data-leak

[6] Als het gaat over generatieve AI, dus ook deepfake video en audio, dan komt het genereren van pornografisch materiaal met daarin de gezichten van bestaande personen die daar geen toestemming voor hebben gegeven, of synthetische kinderporno het meest voor.

[7] https://therecord.media/ai-tool-generates-bec-fraud

[8] https://fd.nl/bedrijfsleven/1478223/hoe-chatgpt-tegen-wil-en-dank-co-piloot-wordt-van-de-cybercrimineel-hag3cao2EK05

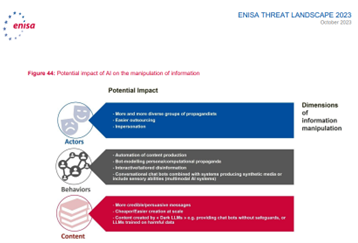

[9] https://www.enisa.europa.eu/publications/enisa-threat-landscape-2023

[10] https://www.spiceworks.com/tech/artificial-intelligence/guest-article/how-chatgpt-could-spread-disinformation-via-fake-reviews/amp/

[11] https://www.linkedin.com/posts/linasbeliunas_game-changer-air-just-launched-the-worlds-ugcPost-7086419334276808704-TMCD

[12] https://research.checkpoint.com/2023/opwnai-cybercriminals-starting-to-use-chatgpt/

[13] https://www.bleepingcomputer.com/news/security/hackers-use-fake-chatgpt-apps-to-push-windows-android-malware/

[14] https://slashnext.com/blog/wormgpt-the-generative-ai-tool-cybercriminals-are-using-to-launch-business-email-compromise-attacks/

[15] https://venturebeat.com/security/how-fraudgpt-presages-the-future-of-weaponized-ai/

[16] https://arxiv.org/pdf/2401.03315.pdf

[17] In dit onderzoek is geëxperimenteerd met 25 fictieve personages in een minecraft achtige game omgeving, waarbij de personages een stukje geschiedenis, context en een aantal intenties meekregen. Voor de interactie maakten ze gebruik van ChatGPT. Het is fascinerend om te lezen hoe de karakters gesprekken met elkaar aangaan, nieuwe mensen leren kennen, hierop reflecteren en vervolgens hun gedrag en acties voor de volgende dag erop aanpassen.

https://arxiv.org/abs/2304.03442