Maatschappelijke impact LLM's

Hieronder ga ik in op de dreigingen, niet op wat de impact is op onderwijs, industrie etc.

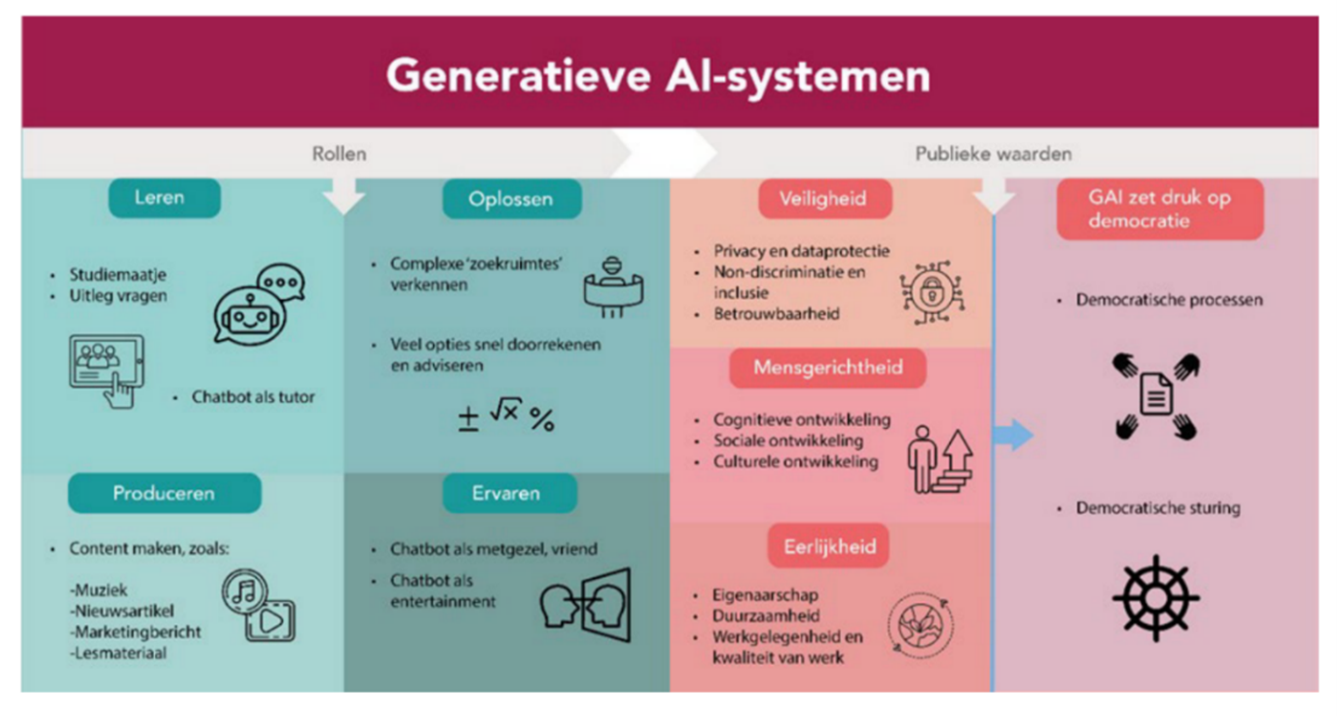

Als het gaat om de mogelijke dreigingen van taalmodellen, komt er steeds meer onderzoek beschikbaar. Generatieve AI, en in het bijzonder de grote taalmodellen, hebben een enorme impact op de samenleving, niet alleen door hun vermogen tot het creëren van audio (muziek, stemmen), beeld, code, tekst en combinaties hiervan. Ook omdat ze steeds vaker ingezet worden als zogenaamde autonome agents, die zelfstandig allerlei interacties en handelingen uitvoeren. Door het vermogen om volstrekt natuurlijke gesprekken te voeren, indien gewenst zelfs in de stijl van bestaande personen en perfect afgestemd op de ontvanger, is het nagenoeg onmogelijk om nog te weten met wie of wat je echt in gesprek bent, zeker als het gecombineerd wordt met deepfake audio en beeld.

Vandaar dat Yuval Harari aangeeft dat “De echte dreiging is dat AI in staat is tot fake intimacy”. “Het beheerst de taal, de menselijke taal, het kan onze zwaktes bespelen, het kan niet alleen waarheden, maar ook leugens, kwaadwillend doen geloven, het kan dat de maatschappij inbrengen, en op die manier kun je niet alleen de wetenschap, maar ook de politiek, de democratie en de economie ondermijnen.”[1]

[1] Uit: De tijd van Peter Werkhoven, Chief Scientist bij TNO, plenaire presentatie tijdens Springtij 2023.

https://www.springtij.nu/de-tijd-van-peter-werkhoven/

Publieke waarden, veiligheid

De integratie in op kinderen gerichte apps heeft ook een zorgelijke kant. Snapchat heeft de aan ChatGPT gekoppelde ‘vriend’(MyAI) bovenaan de vriendenlijst gezet, daarmee is er altijd iemand beschikbaar om mee te communiceren. Niet alleen draagt dit bij aan verslaving, ook wordt, doordat LLM’s niet de betekenis van de woorden snappen, niet ingegrepen als er sprake is ongewenste ontwikkelingen zoals wanneer een kind gegroomd wordt.[3] Er zijn ook zorgen over wat de invloed van deze LLM’s is op de

“ontwikkeling van mensen die deze systemen gebruiken – zowel op cognitief als sociaal vlak. Wat cognitieve ontwikkeling betreft worden er zorgen geuit over het verlies van kennis en kunde van werknemers (deskilling). Als generatieve AI steeds meer cognitieve vaardigheden op het gebied van creativiteit, kritische reflectie en begripsvermogen van ons overneemt ligt het gevaar op de loer dat mensen deze vaardigheden verliezen. Sociale ontwikkeling kan mogelijk negatief worden beïnvloed als AI-systemen steeds meer (intieme) menselijke interacties vervangen.… Automatisering van contact kan mogelijk eenzaamheid en maatschappelijke vervreemding in de hand werken, of afbreuk doen aan onze sociale vermogens.”

Er is nog onvoldoende onderzoek om hier eenduidige conclusies over te trekken.

[1] https://www.rathenau.nl/sites/default/files/2023-12/Scan_Generatieve_AI_Rathenau_Instituut.pdf

[3] https://www.humanetech.com/podcast/the-ai-dilemma. Het gebruik van autonome conversational agents in metal health, en ‘vriendschaps’apps en robotica heeft ook een enorme impact op volwassenen die er, door de gelijkenis op mensachtige communicatie, afhankelijk van worden." https://www.entrepreneur.com/business-news/the-man-who-married-a-hologram-in-japan-can-no-longer/426715

Ondermijning informatie Ecosysteem

Dat iedereen nu laagdrempelig overtuigende content kan genereren en publiceren over elk willekeurig onderwerp, kan een enorme impact hebben op het informatie ecosysteem. Al in 2020 publiceerde Wired een artikel over de mogelijkheid om een “web of lies” te kunnen creëren met synthetische tekst[1]. Deze leugens zouden dan verborgen kunnen worden in reguliere conversaties op sociale media met als gevolg dat dit het online debat en de democratie zou kunnen ondermijnen. Als andere LLM’s (in de vorm van bijvoorbeeld autonome conversational agents) vervolgens op deze content gaan reageren dan ontstaat er een enorme kunstmatige engagement waarmee deze door AI gecreëerde content geprioriteerd wordt in de newsfeeds en tijdlijnen. Want de meeste platformen prioriteren op basis van engagement, hoe vaak wordt iets bekeken, hoe vaak wordt gereageerd. Zo kan desinformatie dus nog effectiever verspreid worden en met nog meer impact. Want als je het overal om je heen ziet terugkomen, dan laat dat toch sporen achter in je hersenen, je weet misschien dat het niet klopt, maar onbewust ga je er toch in geloven. Daarnaast hebben mensen de neiging om mee te gaan in de mening van de massa[2].

Inmiddels zie je dat LLM’s al volop ingezet worden bij de verspreiding van desinformatie.

Hoe kun je nog betrouwbare informatie vinden in deze tsunami aan informatie, hoe duid je informatie en hoe zorg je dat de informatie die jij als bedrijf of overheid wilt delen gevonden wordt en transparant getoetst kan worden op betrouwbaarheid?

Als het gaat over de betrouwbaarheid van informatie kan er sprake zijn van desinformatie of anderszins onbetrouwbare informatie.

[1] https://www.wired.com/story/ai-generated-text-is-the-scariest-deepfake-of-all/

[2] Deze effecten worden aangeduid als de illusory truth en de majority illusion.

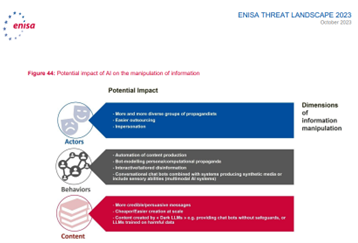

Desinformatie

Bij desinformatie wordt bewust foutieve of misleidende informatie verspreid om de waarheid te verhullen of meningen te beïnvloeden. Als het gaat om desinformatie dan kunnen LLM’s een belangrijk hulpmiddel zijn doordat ze het mogelijk maken desinformatie te creëren en verspreiden[1] met een overtuigendheid en op een schaal zoals nog niet eerder vertoond[2]. Naast de bekende (politieke) voorbeelden van desinformatie[3], zie je ook dat systemen die geautomatiseerd het internet afzoeken in het kader van bijvoorbeeld dreigingsanalyses gemanipuleerd kunnen worden met gegenereerde content[4]. Als laatste is het mogelijk om met specifiek getrainde LLM’s een propaganda-as-a-service[5] dienst te realiseren. Daarnaast blijken de LLM’s ook kwetsbaar voor hacks, zoals interpol beschrijft: “ChatGPT can be vulnerable to attacks during which malicious users intentionally input incorrect or misleading information to manipulate the responses of the model.[6]”

Misinformatie: onbetrouwbare informatie

Het genereren van onbetrouwbare en feitelijk onjuiste informatie kan allereerst gezien worden als gewoon een bekende eigenschap van LLM’s[7]. De systemen zijn gebouwd voor het genereren van tekst op basis van het zo goed mogelijk voorspellen van elk volgend woord, niet voor het genereren van feitelijkheden[8]. De verwachting is daarom niet dat dit gerepareerd kan worden:

“ChatGPT can also give completely wrong answers and present misinformation as fact, writing “answers that sound plausible but are incorrect or make no sense,” the company admits. OpenAI says solving this problem is difficult because there is no source of truth in the data they use to train the model, and supervised training can also be misleading “because the ideal answer depends on what the model knows, rather than of what the human demonstrator knows’.” [9]

Dat de door de LLM’s gegenereerde teksten zo overtuigend zijn, vergroot de schadelijke impact, waarbij het ook nog zo is dat hoe overtuigender de tekst, hoe groter de kans op fouten[10]. In een onderzoek naar Google’s LLM Bard bleken 78 uit de 100 resultaten overtuigende misinformatie te bevatten[11]. Deze misinformatie vindt ondertussen zijn weg naar allerlei kanalen waar mensen er niet op voorbereid zijn, denk aan nieuwsartikelen[12], boeken die worden gerepliceerd[13] of zelfs volledig gegenereerd, wat ook gevaarlijk kan zijn zoals bij gegenereerde boeken over het zelf paddenstoelen plukken[14]. Amazon heeft sowieso een probleem sinds marketeers LLM’s gebruiken om snel goede teksten te genereren zonder daarna een controle uit te voeren.

Ook social media als Twitter (X[15]) en Facebook[16] worden overspoeld door gegenereerde content. Ook zie je steeds meer promotie van (niet bestaande) producten en websites vol clickbait voor de advertentie inkomsten. Voor deze doelen is het niet belangrijk of de teksten kloppen als ze maar overtuigend lezen. Er is een enorm probleem met zogenoemde botshit: Gewoon pure onzin waarbij het voor de maker niets uitmaakt of het klopt of niet als er maar geklikt wordt of hun product er maar geloofwaardig van wordt, want dat genereert geld[17].

Maar het risico is dat mensen valse of onveilige producten kopen en dat de waarheid steeds moeilijker te vinden is tussen alle onzin rond een onderwerp.

Opvallend is dat Google een centrale rol speelt[18] in de verspreiding van advertenties voor deze producten en websites, hoewel ze eraan verdient schaadt dit wel de betrouwbaarheid en aantrekkelijkheid van haar zoekmachine.

Model Collapse

Naarmate steeds meer materiaal op het internet door AI gegeneerd is, worden ook steeds meer ‘hallucinaties’ en desinformatie gepubliceerd op het internet, terwijl dat juist de bron vormt waarmee de modellen getraind worden. De kwaliteit van de modellen kan daardoor afnemen. Dit wordt ‘Model Collapse’[19] genoemd; AI is eating it’s own tail. Het risico is dat we aanvankelijk steeds meer gaan leunen op generatieve AI die uiteindelijk onvoldoende gaat presteren voor de gemaakte toepassingen.[20]

In onderzoek werd een Model steeds weer getraind op basis van synthetische (met AI gegenereerde) teksten, waarbij na 10x het model volledige onzin begon uit te kramen.[21]

[1] https://arstechnica.com/information-technology/2023/08/chatgpt-boosts-crypto-botnet-with-ai-generated-tweets/

[2] https://cset.georgetown.edu/wp-content/uploads/CSET-Truth-Lies-and-Automation.pdf

[3] Voorbeelden van beïnvloedingscampagnes met AI in de context van de oorlog in Oekraine: https://go.recordedfuture.com/hubfs/reports/ta-2023-1205.pdf https://dfrlab.org/2023/12/14/massive-russian-influence-operation-targeted-former-ukrainian-defense-minister-on-tiktok/

[4] https://arxiv.org/abs/2102.04351

[5]https://arxiv.org/abs/2112.05224 en https://arxiv.org/abs/2301.04246

[6] file:///C:/Users/Acer/Downloads/ChatGPT-Impacts%20on%20Law%20Enorcement-%20August%202023.pdf

[7]

https://www.businessinsider.nl/hallucinerende-artificial-intelligence-is-juist-goed-en-de-toekomst-van-ai-heeft-enge-verrassingen-in-petto-volgens-topman-sam-altman-van-het-bedrijf-achter-chatgpt/

“This system card analyzes GPT-4…. First, we highlight safety challenges presented by the model’s limitations (e.g., producing convincing text that is subtly false) and capabilities (e.g., increased adeptness at providing illicit advice, performance in dual-use capabilities, and risky emergent behaviors). Finally, we demonstrate that while our mitigations and processes alter GPT-4’s behavior and prevent certain kinds of misuses, they are limited and remain brittle in some cases. This points to the need for anticipatory planning and governance.”

https://cdn.openai.com/papers/gpt-4-system-card.pdf

[8]

https://www.washingtonpost.com/technology/2023/08/07/ai-eating-disorders-thinspo-anorexia-bulimia

Zie ook dit relaas: https://www.linkedin.com/posts/anne-sey-08518018_japan-deshima-siebold-activity-7059047224336338944-CCGO

[9] https://medium.com/@Levente22/could-chatgpts-ai-ever-replace-humans-6c142b63cbae

[10] https://www.sciencedirect.com/science/article/abs/pii/S0262407923007893?via%3Dihub

[11] https://counterhate.com/research/misinformation-on-bard-google-ai-chat/

[12]

https://twitter.com/EliotHiggins/status/1635623445164851203?s=20

https://www.engadget.com/cnet-corrected-41-of-its-77-ai-written-articles-201519489.html

https://thehill.com/media/4084032-editor-lashes-out-after-company-publishes-ai-generated-article-riddled-with-errors/

https://www.cbsnews.com/news/microsoft-ai-travel-guide-ottawa-food-bank/

[13] https://www.washingtonpost.com/technology/2023/05/05/ai-spam-websites-books-chatgpt/

[14] https://www.404media.co/ai-generated-mushroom-foraging-books-amazon/

[15] https://techcrunch.com/2024/01/10/it-sure-looks-like-x-twitter-has-a-verified-bot-problem/

[16] https://www.404media.co/facebook-is-being-overrun-with-stolen-ai-generated-images-that-people-think-are-real/

[17] https://www.theguardian.com/commentisfree/2024/jan/03/botshit-generative-ai-imminent-threat-democracy

[18] https://futurism.com/content-farms-ai

[19] https://www.popularmechanics.com/technology/a44675279/ai-content-model-collapse/ https://arxiv.org/pdf/2305.17493.pdf?trk=feed-detail_comments-list_comment-text

[20] https://www.techtarget.com/whatis/feature/Model-collapse-explained-How-synthetic-training-data-breaks-AI

[21] https://arxiv.org/pdf/2305.17493.pdf

Voetnoten:

[2] https://podcasts.apple.com/nl/podcast/the-real-python-podcast/id1501905538?i=1000629648912

[3] https://www.nature.com/articles/s41587-022-01618-2

[4] Language models in molecular discovery https://arxiv.org/abs/2309.16235

[5] https://arxiv.org/ftp/arxiv/papers/2304/2304.05332.pdf

[7] https://time.com/6266923/ai-eliezer-yudkowsky-open-letter-not-enough/