Grote taalmodellen (LLM's) als ChatGPT

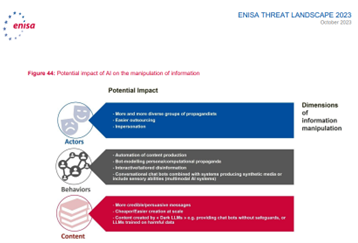

In 2025 zal 90% van de digitale content synthetisch zijn, met de komst van ChatGPT werd opeens heel zichtbaar dat het internet heel rap gevuld wordt met door AI gegenereerde of gemanipuleerde content

De release van ChatGPT door OpenAI eind vorig jaar is revolutionair geweest, daarmee kwam de mogelijkheid om mensachtige taal te genereren op basis van LLM’s, opeens in handen van het grote publiek. Sinds de openbare lancering van ChatGPT eind november 2022, bereikte de chatbot binnen twee maanden tijd de grens van 100 miljoen gebruikers. Zo maakten naar verwachting in de eerste vier maanden van 2023 al zo’n anderhalf miljoen

Nederlanders gebruik van ChatGPT. ChatGPT is een prototype van een chatbot met kunstmatige intelligentie, ontwikkeld door OpenAI en gespecialiseerd in het voeren van dialogen met een (menselijke) gebruiker via een chatvenster. Deze chatbot bestaat uit een groot taalmodel (LLM – large language model) en een extra laag kunstmatige intelligentie om dit model in te zetten als chatbot. Het LLM produceert teksten op basis van de gigantische hoeveelheid informatie waar het op getraind is. Dit genereren gebeurt op basis van een mathematisch begrip van de woorden in de data waardoor de teksten heel plausibel klinken, maar niet noodzakelijk correct zijn.

Werking LLM’s

Bij LLM’s is de kunstmatige intelligentie dus getraind op een hele grote hoeveelheid digitale tekst. Denk aan artikelen van grote nieuwswebsites, elektronische boeken, wetteksten, fora en Wikipedia. Zo leert het taalmodel over de structuur, het gebruik van taal, en de relatie tussen woorden of delen van woorden in diverse contexten.

Vervolgens heeft het model zichzelf getraind in het voorspellen van teksten. Dit doet het door uit bestaande tekst een deel weg te laten om daarna zelf te voorspellen welke woorden er logischerwijs op zouden moeten volgen. Dit is pure wiskunde, kansberekening; op basis van alle relaties die het kent, voorspelt het wat het meest waarschijnlijke volgende woord moet zijn en dat voor ieder woord opnieuw. Uiteindelijk vergelijkt het zijn eigen resultaat met de oorspronkelijke tekst. Afhankelijk van hoe goed of slecht het was, past het zijn kansberekening aan, waarbij het woord dat er op had moeten volgen de volgende keer een hoger gewicht (dus kans) krijgt in die context, waardoor hij daar sneller voor zal kiezen.

Dit is enorm complex, bij GPT3 ging het om 175 miljard gewichtjes, daarom heeft het dus honderden miljarden woorden nodig om te leren, en een supercomputer om honderden miljarden keren dezelfde tekstvoorspellingen met zichzelf uit te voeren om zich te trainen. De resulterende structuur van gewichtjes kun je zien als het taalmodel.

In de praktijk wordt er ook nog steeds gecontroleerd door mensen. Om de kwaliteit te verbeteren, maar vaak ook als gevolg van alle incidenten, dus om ongewenste content te voorkomen. Want wellicht heeft het model zijn werk goed gedaan, maar het is getraind op het internet, toch ook het afvoerputje waarin bijvoorbeeld veel extremistische en racistische teksten voorkomen. [2]

Door al deze training is het taalmodel heel goed geworden in het herkennen van patronen in taal en het gebruik van deze patronen om te voorspellen wat er waarschijnlijk volgt op een gegeven stuk tekst. Het enige dat het doet is berekenen wat het meest waarschijnlijke volgende woord is, waarbij het wel context meeneemt die jij in je instructie hebt meegegeven, bijvoorbeeld dat iets moet rijmen. Dit gaat razendsnel, maar wel woord voor woord! De huidige taalmodellen (LLM’s) zijn zo goed dat gesprekken ermee volstrekt natuurlijk aanvoelen en je niet door hebt dat je met een machine in plaats van een mens praat.

Rondom LLM’s hangt een enorme hype, waarbij steeds allerlei gunstige eigenschappen en praktische toepassingsmogelijkheden groots in het nieuws komen. Vaak komen deze van leveranciers, consultants of het betreft individuele anekdotische ervaringen. Zo geven mensen aan dat het een uitstekend hulpmiddel is voor het samenvatten van documenten en mails (die vervolgens ook door deze LLM’s namens jou beantwoord kunnen worden). Bij doorvragen blijken ze echter zelden een controle te hebben uitgevoerd door het oorspronkelijke materiaal zelf te lezen.

[2] Onderzoek van de Groene heeft laten zien dat de AI van bijvoorbeeld het rechtsextremistische forum Stormfront ongeveer evenveel leert als van RTL nieuws.

https://www.groene.nl/artikel/dat-zijn-toch-gewoon-al-onze-artikelen

Geen feiten

Er is dus geen grote database waarin het kan zoeken, of op basis waarvan het de betekenis van een woord leert begrijpen. Een veelgemaakte fout is dat mensen het gebruiken als zoekmachine, maar het is dus puur tekstgeneratie.

Dit ondervond ook een advocaat die via ChatGPT naar jurisprudentie in zijn voordeel zocht. Maar stel je de zoekvraag “welke jurisprudentie geeft mij gelijk in deze zaak” dan genereert het teksten die lijken op jurisprudentie in een context die lijkt op deze zaak. Vraag je vervolgens welke rechtbanknummers hierbij horen, dan vraag je het systeem eigenlijk om tekst te genereren die lijkt op rechtbanknummers, dus dan genereert daarop lijkende nummers.

In de praktijk geeft dit niet bestaande of foute nummers (toeval daargelaten). Men noemt dit hallucineren, maar eigenlijk doen de LLM’s precies waar ze voor gemaakt zijn plausibele teksten genereren. Vandaar dat wordt afgeraden om LLM’s te gebruiken als feitelijkheden belangrijk zijn.

“We still really cannot guarantee that any given system will be honest, harmless, or helpful, rather than sycophantic, dishonest, toxic or biased. And AI researchers have been working on these problems for years. It’s foolish to imagine that such challenging problems will all suddenly be solved. I’ve been griping about hallucination errors for 22 years; people keep promising the solution is nigh, and it never happens. The technology we have now is built on autocompletion, not factuality.[1]”

Onderzoek wijst helaas uit dat hoe overtuigender het antwoord is van AI-zoekmachines hoe groter de kans dat het fout is[2]. En dat vergroot de maatschappelijke impact nu deze complexe tools in handen zijn gegeven van het grote publiek zonder handleiding, training of gedegen testfase. Feitelijk zijn we daarmee lab-ratten geworden in een groot experiment.

Dat neemt niet weg dat het echt voordelen kan hebben[3]. Maar wil je een bewuste afweging maken tussen kosten (zoals potentieel kwaliteitsverlies[4] en veiligheidsrisico’s) en baten (zoals tijdswinst en besparing op capaciteit), dan zul je zelf uitgebreid onderzoek moeten doen, zowel in een op de praktijk gebaseerde lab-omgeving (experimenten) als naar reeds gepubliceerd (wetenschappelijk) onderzoek.

[1] https://garymarcus.substack.com/p/what-if-generative-ai-turned-out

[2] https://www.sciencedirect.com/science/article/abs/pii/S0262407923007893?via%3Dihub

[3] Deze liggen vooral op het gebied van innovatie, ideation en genereren van content. Onderwerpen die goed passen bij LLM’s, gemiddeld scoorden mensen die ChatGPT hiervoor gebruikten 40% beter. Uit dit onderzoek bleek ook dat wanneer het werd ingezet voor ‘business problem solving’ de groep die ChatGPT gebruikte 23% slechter scoorde dan de groep zonder ChatGPT. Belangrijke kanttekenin is dat wel ingeleverd wordt op diversiteit. Voor meer verrassende inzichten uit dit eerste brede praktijkonderzoek: https://www.bcg.com/publications/2023/how-people-create-and-destroy-value-with-gen-ai

De chatbot op je website kun je trouwens ook beter volgens een script laten werken: Koeriersdienst DPD heeft zijn chatbot uitgeschakeld nadat die het bedrijf had beledigd en scheldwoorden had gebruikt in een gesprek met een klant.

https://www.vrt.be/vrtnws/nl/2024/01/21/chatbot-ai-dpd-koerierdienst-ontslagen-ashley-beauchamp/ OpenAI gebruikt zelf ook nog steeds een gescripte chatbot in plaats van ChatGPT.

[4]

https://www.theregister.com/2022/12/05/stack_overflow_bans_chatgpt/

https://www.cbsnews.com/news/microsoft-ai-travel-guide-ottawa-food-bank/

Emergente ontwikkelingen

Door de enorme hoeveelheid tekst waarop getraind is, ontstaan nieuwe eigenschappen die ervoor niet voorzien waren. Zo bleek ChatGPT opeens in staat te communiceren in het Perzisch ondanks dat het daar niet op getraind was. Daarnaast gaat het bij taal niet alleen om geschreven tekst, LLM’s blijken ook goed te kunnen ondersteunen bij simpel programmeerwerk[1], maar ook daarbij is het niet altijd betrouwbaar.

“ You can give it the same prompt and it will give you different code every time, that’s an unreliability, an inconsistency….. maybe sometime it’s fine, but other times just 99% but for some little bug that will go unnoticed until it’s in production and running somewhere… Beginners, they don’t know what they do not know…[2]”

Dankzij de omvangrijke training zijn LLM’s in staat goede suggesties te doen als het gaat over domeinen waarover veel gepubliceerd is. Het gebruik van taalmodellen levert daardoor al nieuwe inzichten in de onderzoekswereld, zoals in bioengineering waarbij eiwitsequenties gebouwd kunnen worden die nog niet zijn voorgekomen in onze evolutie[3] of het ontdekken van nieuwe moleculen[4]

Onderzoekers van de Carnegie Mellon universiteit toonden zelfs aan dat LLM’s in staat zijn autonoom (dus zonder menselijke tussenkomst) wetenschappelijke experimenten te ontwerpen, plannen en uitvoeren in de fysieke wereld wanneer ze verbonden worden met een chemisch laboratorium[5]. Dit kan enorme vooruitgang brengen, maar de onderzoekers waren zich ook erg bewust van de risico’s bij malafide inzet, het bracht hen tot de volgende oproep:

We strongly believe that guardrails must be put in place to prevent this type of potential dual-use of large language models. We call for the AI community to engage in prioritizing safety of these powerful models. We call upon OpenAI, Microsoft, Google, Meta, Deepmind, Anthropic, and all the other major players to push the strongest possible efforts on safety of their LLMs. We call upon the physical sciences community to be engaged with the players involved in developing LLMs to assist them in developing those guardrails.

Kort na het uitbrengen van de eerste publiek toegankelijke LLM’s werd er al vanuit verschillende hoeken opgeroepen tot een pauze[6] of zelfs stop[7] op de LLM ontwikkelingen[8]. Ook de makers achter de systemen pleiten publiek voor regulering[9], maar in de praktijk handelen ze er niet naar. En nu er regulering lijkt te komen, lobbyen[10] ze vooral voor zelfregulering, en beloven ze daar nu dan toch mee te beginnen….[11]

Er is voor miljarden in geïnvesteerd, de grote techbedrijven achter deze toepassingen zitten in een concurrentiestrijd waarbij het essentieel is zo snel mogelijk zoveel mogelijk gebruikers afhankelijk te maken. Hun reactie is niet het terugtrekken van de tools, maar het aanpassen van de contentfilters.

Dat geldt niet alleen bij LLM’s, recent kwam naar buiten dat een belangrijke databases waarop AI voor het genereren van beelden getraind is, veel kinderporno bevat. Dat is de reden waarom dergelijke tools zo geschikt zijn voor het genereren van kwalitatief goede virtuele kinderporno. Dit nieuws heeft niet geleid tot het opnieuw uitbrengen van tools op basis van opnieuw met ander materiaal getrainde modellen. Alleen de mogelijke vraagstelling (contentfilters) wordt verder ingekaderd.

Dit pleisters plakken lost het oorspronkelijk probleem niet op en mensen blijven workarounds vinden om de nieuwe filters te omzeilen. Onderzoekers zijn er nu zelfs in geslaagd een AI chatbot te trainen die zelf nieuwe methoden genereert om de contentfilters te ontwijken[12].

De politie heeft als missie “waakzaam & dienstbaar aan de waarden van de rechtstaat”. Bovenstaande laat zien dat er naast de kansen die LLM’s bieden ook grote risico’s zijn, en dat inzet zorgvuldig moet worden overwogen. Niet alleen op de voordelen in een specifieke toepassing, ook op de impact op samenleving en veiligheid nu en in de toekomst. In het volgende hoofdstuk wordt hierop in gegaan.

Voetnoten:

[2] https://podcasts.apple.com/nl/podcast/the-real-python-podcast/id1501905538?i=1000629648912

[3] https://www.nature.com/articles/s41587-022-01618-2

[4] Language models in molecular discovery https://arxiv.org/abs/2309.16235

[5] https://arxiv.org/ftp/arxiv/papers/2304/2304.05332.pdf

[7] https://time.com/6266923/ai-eliezer-yudkowsky-open-letter-not-enough/