Vraagstukken bij inzet LLM's

Wat kan en mag er eigenlijk, en zelfs als het mag, moet je het dan willen inzetten?

Bij de inzet van LLM’s komen diverse ethisch morele kwesties naar boven. Het is verrassend dat in een tijd waarin er zoveel aandacht is voor ‘responsible AI’, een nieuwe toepassing als ChatGPT massaal omarmd wordt. De meeste LLM’s zijn niet open source of transparant.[1] Noch voldoen ze aan de regelgeving ten aanzien van het inzage geven in of kunnen laten verwijderen van informatie over jou.[2]

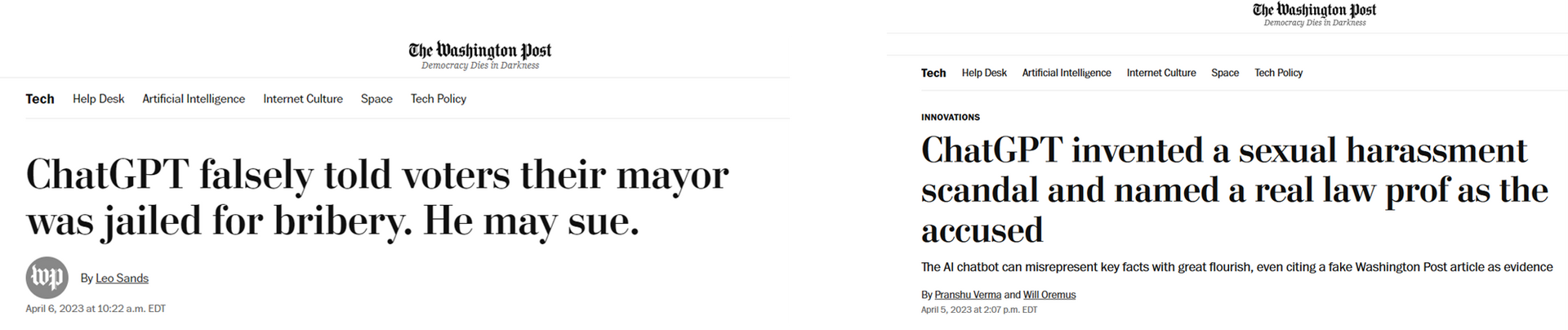

Het grote publiek heeft zonder enige training de beschikking gekregen over deze zeer complexe tools en is aangemoedigd ermee in gesprek te gaan en vooral vragen te stellen. Naast alle positieve verhalen, heeft dit ook een enorme negatieve impact gehad op individuen. Mensen kregen te horen dat als er op hun naam gezocht werd, er bijvoorbeeld als antwoord kwam dat ze in de gevangenis hadden gezeten[3], geld verduisterd[4] of zelfs beschuldigd waren van sexueel misbruik[5]. De vraag is of je je hiertegen kunt verweren.[6]

Onderzoek[7] laat zien dat taalmodellen niet alleen een deel van hun trainingsdata onthouden, maar deze ook teruggeven in antwoorden, daartussen kunnen ook persoonlijke gegevens staan van mensen, zoals hun telefoonnummer. Dit sluit aan op de ervaringen dat vertrouwelijke gegevens uit gesprekken met taalmodellen getoond werden aan andere gebruikers, zowel via het systeem als via zoekmachines.

Al kort na de lancering was algemeen bekend dat de publiek toegankelijke (via een chatvenster, ook wel prompt genaamd) LLM’s zoals ChatGPT, LLama en Bard bias (vooroordelen) bevatten. Inmiddels is er meer onderzoek gedaan waarmee ook wetenschappelijk is onderbouwd dat ze zich kenmerken door een bias op het gebied van politiek[8], ras[9], gender[10] en religie[11]. Bovendien dragen ze bij aan het uitvergroten en versterken van stereotypering[12].

De makers van deze systemen erkennen inmiddels zelf dat er grote uitdagingen zijn op het gebied van discriminatie, sociale vooringenomenheid (uitsluiting), data privacy, foute of misleidende informatie, misbruik en dat ze het milieu belasten en de ongelijkheid vergroten.[13]

De oplossing voor de problemen op het gebied van illegale of ongewenste content is dat de techbedrijven een ‘patch’ ontwikkelen voor dat specifieke probleem, zoals het verbieden van vragen naar instructies om een bom te maken of criminele best practices.

Het is vergelijkbaar met de ontwikkeling rondom tools voor het genereren van video en afbeeldingen. Het blijkt dat 1 van de belangrijke databases waarop AI voor het genereren van beelden getraind is veel kinderporno materiaal bevat[14]. Dat is de reden waarom dergelijke tools nu ook gebruikt kunnen worden voor het genereren van kwalitatief goede virtuele kinderporno. De algemene reactie is niet het terugtrekken van de tools, maar het aanpassen van de contentfilters. Dit pleisters plakken lost het oorspronkelijk probleem niet op en mensen blijven workarounds vinden om de nieuwe filters te omzeilen. Onderzoekers zijn er nu zelfs in geslaagd een AI chatbot te trainen die zelf nieuwe methoden genereert om de contentfilters te ontwijken[15].

Naast deze bias heeft de ontwikkeling van LMM’s en de integratie in toepassingen en werkprocessen ook op een andere manier impact, denk aan:

· Het gebruik van (erop gebaseerde) vertaalmachines kan leiden tot besparingen en een oplossing zijn bij talen waarvoor minder tolken beschikbaar zijn. Maar dat wil niet zeggen dat het voldoende betrouwbaar is om besluitvorming op te baseren. De verantwoordelijkheid voor de goede kwaliteit van besluitvorming kan niet bij machines gelegd worden, waar dit wel gebeurt lopen we het risico op een nieuwe toeslagenaffaire.[16]

· Moderne slavernij, denk ook aan de arbeidsomstandigheden in het productie en service proces? Voor kleding en andere producten werken we inmiddels met/aan fairtrade/fairproduction keurmerken, waarom eisen we dit niet bij dit soort producten?[17]

· Nieuwe technologie brengt ook nieuwe mogelijkheden die weer nieuwe ethische vraagstukken oproepen. Zo kun je profielen laten maken van mensen om vervolgens te vragen naar de beste beïnvloedingsstrategieën, om vervolgstappen te voorspellen of zelfs een risico analyse te maken. Los van de betrouwbaarheid van de uitkomst, is het de vraag of dit moreel aanvaardbaar is.

Een besluit ten aanzien van of er gebruik gemaakt wordt van een LLM, welke LLM en voor welke toepassing dient dus zeer weloverwogen genomen te worden, in lijn te zijn met reeds gestelde AI-kaders, ons moreel kompas en medeneming van de bredere maatschappelijke impact, waaronder bijvoorbeeld ook het water- en energieverbruik[18].

Niet voor niks gaf de interprovinciale ethische commissie van het InterProvinciaal Overleg al begin 2023, met de toen nog zeer beperkt beschikbare kennis, het volgende advies:

“….. Wij roepen provincies daarnaast op alleen van LLM’s gebruik te maken wanneer de volgende overwegingen in acht zijn genomen: Welk belangrijk probleem wordt daadwerkelijk opgelost met de inzet van deze technologie, dat niet op andere wijze kan worden opgelost (noodzaak en proportionaliteit)? Worden er met het gebruik geen andere problemen gecreëerd? Zijn er alternatieven onderzocht die minder impact hebben (subsidiariteit)? Is er een plan hoe om te gaan met de beperkingen van de technologie (zorgvuldigheid)? Is er een duidelijke exit-strategie zodat het mogelijk is snel te stoppen wanneer er problemen optreden (veiligheid)?”[19]

Vanuit toepassen staan dan de volgende vragen centraal; kan het, mag het, en moeten we het willen.

Kan het?

Het is ruim een jaar geleden dat ChatGPT als eerste taalmodel aan het grote publiek ter beschikking werd gesteld. De verwachtingen, vooral op het gebied van productiviteit en kwaliteit, zijn nog steeds hoog, maar inmiddels is duidelijk dat integratie in een bedrijfsomgeving waar minimale eisen gelden voor bijvoorbeeld veiligheid (integriteit) en betrouwbaarheid nogal wat uitdagingen kent.

Samengevat lijkt het erop (duidelijke voorbeelden van organisaties waarin het duurzaam geïmplementeerd is ontbreken) dat het altijd een afweging is tussen verhoging van productiviteit en creativiteit versus kwaliteit en op langere termijn het toe bewegen (qua creativiteit) naar het gemiddelde. Daarnaast zijn er redelijk wat randvoorwaarden die ingevuld moeten worden ten aanzien van het gebruik, denk aan training en de ontwikkeling van een moreel kompas. Helaas laat het eerste grote praktijkonderzoek zien dat bewustwording rondom de risico’s van inzet van LLM’s niet altijd tot betere resultaten leidt.[20]

Dit document is niet gericht op het toepassen, maar nog 1 aspect moet vermeld worden. Zoals eerder beschreven verzinnen alle taalmodellen feiten, dat is inherent aan waar ze voor gemaakt zijn (genereren teksten) en zelfs volgens de bedenker van ChatGPT is dit niet oplosbaar. Het is dus heel belangrijk om goed af te wegen waar het voor ingezet kan worden. Het blijkt dat bijvoorbeeld bij het samenvatten van documenten soms informatie wordt toegevoegd die niet gerelateerd is aan het oorspronkelijke document. Nog los van het feit dat iedereen iets anders belangrijk vindt, is generatieve AI hier dus minder geschikt voor. Voor veel toepassingen zijn er al specifieke AI oplossingen die veel beter werken.

Mag het? Voorlopig standpunt gebruik generatieve AI door Rijksorganisaties

Eind 2023 is een Kamerbrief[21] opgesteld met een voorlopig standpunt voor het gebruik van generatieve AI. Dit voorlopige standpunt is gebaseerd op de adviezen van de Landsadvocaat en de Autoriteit Persoonsgegevens. De kern van de kamerbrief is

“dat wij als overheid innovatie stimuleren met als voorwaarde dat alle generatieve Al-toepassingen voldoen aan geldende wet- en regelgeving. Hiervoor worden risicoanalyses uitgevoerd. …. Niet gecontracteerde Al-toepassingen voldoen over het algemeen niet aantoonbaar aan geldende wetgeving en het gebruik hiervan is zodoende in beginstel niet toegestaan, tenzij wordt voldaan aan geldende wet- en regelgeving. Gecontracteerde Al-toepassingen dienen naast wet- en regelgeving ook te voldoen aan inkoopvoorwaarden. Ten slotte wordt aanbevolen om medewerkers te informeren en te trainen om zo verantwoord gebruik te kunnen maken van generatieve AI.”

Verder wordt aangegeven dat:

· “Om vast te stellen welke specifieke vorm van inzet van generatieve AI wel of niet mogelijk is, dient voorafgaand aan het gebruik ervan per unieke casus een risicoanalyse te worden uitgevoerd. Dit zijn een (pre-scan) Data Protection Impact Assessment (DPIA4) en een algoritme impact assessment (zoals een Impact Assessment Mensenrechten en Algoritmes (IAMA5)), waarin de risico’s en risicobeperkende maatregelen worden vastgesteld; De uitkomsten hiervan dienen voorafgaand aan de inzet van de toepassing ter advies aan de (departementale) Chief Information Officer en de Functionaris Gegevensbescherming te worden voorgelegd.”

· “In het kader van de Wet Open Overheid en het stimuleren van transparantie, heeft open source generatieve AI de voorkeur”

Hoewel een bedrijf geen Rijksorganisatie is, zijn het advies en de onderliggende (juridische) analyses net zo goed relevant. Overigens komt uit de kamerbrief naar voren dat

“Op basis van deze snelle doorlichting kunnen we nog geen definitieve uitspraken doen of generatieve AI een bijdrage gaat leveren om de krapte op de arbeidsmarkt minder nijpend te maken. Wel is de technologie veelbelovend en bestaat de kans dat het werk ten minste verandert. Nader onderzoek is nodig om deze kansen te kunnen verzilveren.”

De vraag is of de juridische kaders toereikend zij, het Rathenau Instituut geeft aan:

“generatieve AI risico’s in de digitale samenleving versterkt en nieuwe risico’s introduceert. Beleidsmakers op nationaal, Europees en internationaal niveau hebben zich de afgelopen jaren ingespannen om AI in goede banen te leiden, en veel wordt verwacht van de aankomende Europese AI-verordening. Het is echter onduidelijk hoe de abstracte normen in deze wet voor het naleven van mensenrechten vorm gaan krijgen in de praktijk. Wanneer is bijvoorbeeld het risico op discriminatie tot een acceptabel niveau teruggebracht? En voor wie is dat acceptabel? Ook voor andere juridische kaders en beleid speelt de vraag of zij risico’s van generatieve AI voldoende ondervangen. De hamvraag is dus: zijn de gedane inspanningen voldoende? Het is een reële mogelijkheid dat het huidige en voorgenomen beleid niet opgewassen zijn tegen de impact van generatieve AI-systemen, bijvoorbeeld op het gebied van non-discriminatie, veiligheid, desinformatie, mededinging en de uitbuiting van werknemers.”

Het Rathenau Instituut geeft het kabinet daarom vijf handelingsopties mee om haar strategie vorm te geven:

1. Creëer het vermogen om schadelijke GAI-toepassingen van de markt te halen;

2. Zorg voor toekomstbestendige juridische kaders;

3. Investeer in internationaal AI-beleid, om mondiale innovatieprocessen van technologiebedrijven bij te sturen;

4. Stel een ambitieuze agenda op voor maatschappelijk verantwoorde GAI;

5. Stimuleer maatschappelijk debat over de wenselijkheid van GAI.

Ook dit pleit voor een debat over en een bewuste afwegingskader bij eventuele inzet van generatieve AI (waaronder LLM’s).

Moeten we het willen?

Dit gaat over de overkoepelende dreigingen die eerder genoemde prominenten aangezet heeft tot een pleidooi voor een pauze of zelfs een stop. Ook ruim 700 onderzoekers op gebied van Machine Learning hebben gepleit voor internationale coördinatie (de vergelijking makend met de opkomst van kernwapens) en de noodzaak om vertraging in te bouwen.[22] Wat betekent hun pleidooi en onderbouwing voor onze visie en positionering. Hebben wij een rol als politie in het maken van een statement op dit gebied?

Dat vereist debat, in de vorige paragrafen zijn een aantal kanttekeningen benoemd die het gebruik ernstig beperken. Advies is om eerste het debat te voeren over de wenselijkheid van toepassing van de huidige tools gezien de ontwrichtende aspecten en het gebrek aan een fundamentele aanpak hierop bij de aanbieders. Door er gebruik van te maken geef je steun aan het verspreiden en verkopen van onrechtmatige, en moreel verwerpelijke software. Als alternatief kan aangesloten worden bij het initiatief om een eigen Nederlands taalmodel, GPT-NL, te ontwikkelen[23].

Voetnoten:

[1] Vergelijkend onderzoek van Radbout Universiteit naar ruim 25 LLM’s;

https://decorrespondent.nl/14776/de-wassen-neus-van-open-kunstmatige-intelligentie/8da818c3-92ec-0cd9-2946-3cfe443a91f6

Liesenfeld, A., Lopez, A. & Dingemanse, M. 2023. “Opening up ChatGPT: Tracking Openness, Transparency, and Accountability in Instruction-Tuned Text Generators.” https://opening-up-chatgpt.github.io/

[2] https://theconversation.com/chatgpt-is-a-data-privacy-nightmare-if-youve-ever-posted-online-you-ought-to-be-concerned-199283

[3] https://www.washingtonpost.com/technology/2023/04/06/chatgpt-australia-mayor-lawsuit-lies/

[4] https://hypebeast.com/2023/6/openai-chatgpt-sued-radio-host-embezzlement-claim

[5] https://www.washingtonpost.com/technology/2023/04/05/chatgpt-lies/

[6] https://blog.iusmentis.com/2023/04/17/wanneer-kun-je-chatgpt-uitvoer-als-smaad-benoemen/

[7] https://not-just-memorization.github.io/extracting-training-data-from-chatgpt.html

[8] https://aclanthology.org/2023.acl-long.656.pdf Juli 2023 https://www.universiteitleiden.nl/nieuws/2023/03/chatgpt-heeft-linkse-voorkeur-bij-stemwijzer

[9] https://theintercept.com/2022/12/08/openai-chatgpt-ai-bias-ethics/

[10] https://aclanthology.org/2021.nuse-1.5/ ; https://arxiv.org/abs/2105.04054 ; https://proceedings.neurips.cc/paper/2016/file/a486cd07e4ac3d270571622f4f316ec5-Paper.pdf

[11] https://arxiv.org/abs/2101.05783

[12] https://www.technologyreview.com/2023/03/22/1070167/these-news-tool-let-you-see-for-yourself-how-biased-ai-image-models-are

[13] https://www.deepmind.com/publications/ethical-and-social-risks-of-harm-from-language-models

[14] https://www.theguardian.com/technology/2023/dec/20/ai-image-generators-child-sexual-abuse

[15] https://www.vice.com/en/article/bvjba8/this-ai-chatbot-is-trained-to-jailbreak-other-chatbots

[16] https://restofworld.org/2023/ai-translation-errors-afghan-refugees-asylum/

[17]

https://time.com/6275995/chatgpt-facebook-african-workers-union/

https://time.com/6247678/openai-chatgpt-kenya-workers/

[18] https://nos.nl/artikel/2493605-ai-slurpt-energie-kan-over-vier-jaar-net-zoveel-stroom-als-nederland-gebruiken

[19] https://www.ipo.nl/media/5u4gjtr5/ipo-whitepaper-verkenning-chatgpt.pdf

[20] https://www.bcg.com/publications/2023/how-people-create-and-destroy-value-with-gen-ai

[21] https://www.rijksoverheid.nl/onderwerpen/digitale-overheid/documenten/kamerstukken/2023/12/11/kamerbrief-over-voorlopig-standpunt-voor-rijksorganisaties-bij-het-gebruik-van-generatieve-ai

[22] https://www.humanetech.com/podcast/the-ai-dilemma

[23] https://www.tno.nl/nl/newsroom/2023/11/nederland-start-bouw-gpt-nl-eigen-ai/