Morele vragen bij de inzet van deepfakes

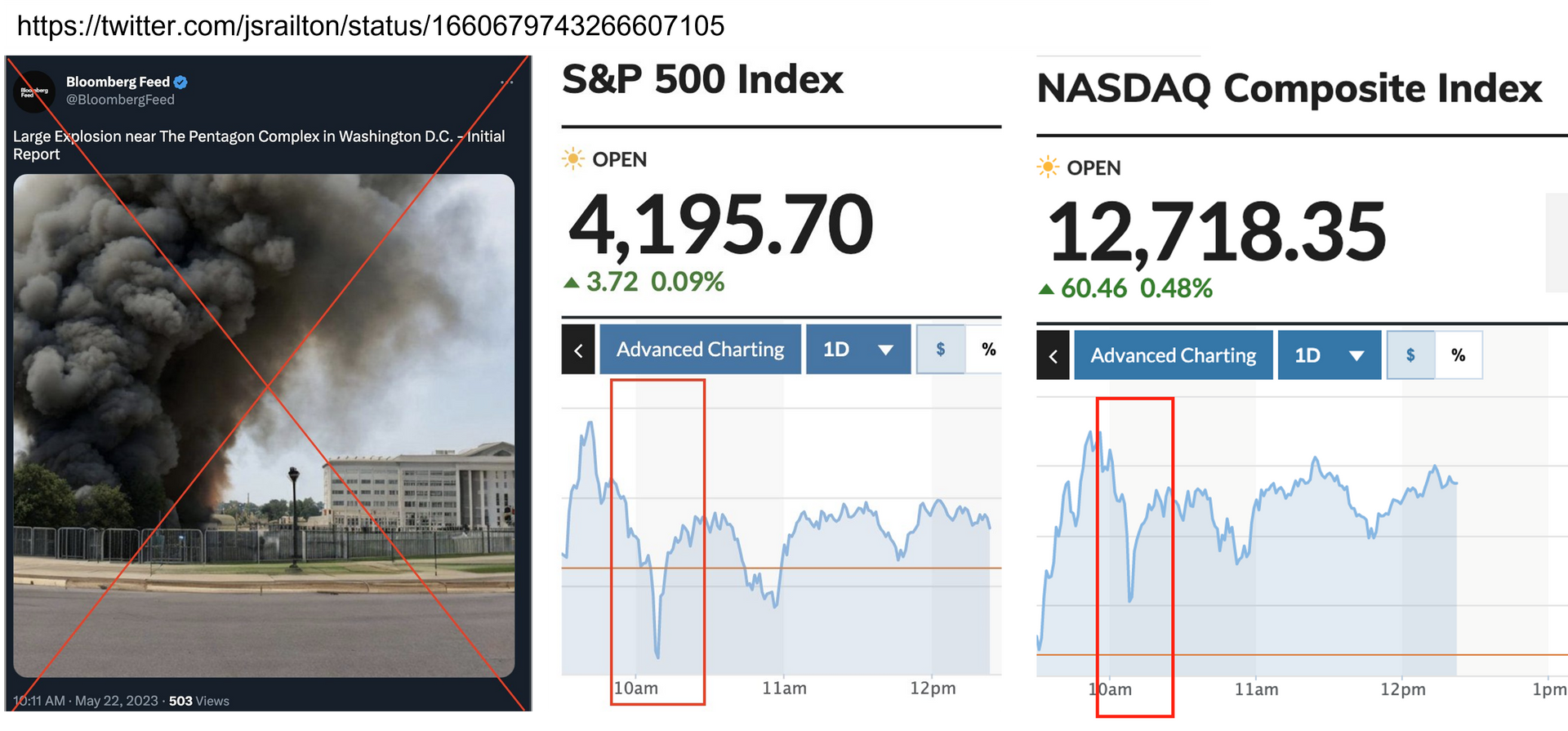

De grootste maatschappelijke impact van deepfakes (en eigenlijk de synthetisering van media in het algemeen) is dat als steeds meer nep wordt, het vertrouwen in informatie en daarmee in potentie in de rechtstaat wordt ondermijnd. Zoals experts aangeven:

" deepfakes generate and justify false beliefs” &

“may prevent people from acquiring true beliefs."

De kosten voor het verifiëren van informatie nemen toe, zowel voor organisaties als individuen.

Door deze ondermijnende impact op het vertrouwen in de informatie(voorziening) is, ook als iets kan en mag, de belangrijkste vraag: “wat vinden we wel en niet moreel aanvaardbaar als het gaat om de inzet van deepfake technologie”?

Dit moet niet alleen vanuit het individuele/organisatieperspectief bekeken worden, maar ook vanuit het bredere perspectief van de samenleving. Het ‘perspectief van de samenleving’, is echter een vaag begrip, daarom ben ik online op zoek gegaan naar wat mensen bezighoudt als het gaat om inzet van deepfakes. Dus geen wetenschappelijk onderzoek, maar het biedt duidelijk haakjes voor vragen die je jezelf en anderen kunt stellen.

Het zal ook niet volledig zijn, dus laat het vooral weten als je andere, aanvullende inzichten hebt opgedaan! Onderaan deze blog vind je een optie voor contact.

Ethisch perspectief

Vanwege de maatschappelijke impact van deepfakes wordt vaak gewaarschuwd tegen het normaliseren van het gebruik, zeker als het gaat om het klonen van bestaande mensen. Regelgeving ontbreekt als het gaat om post mortem privacy, en ook is het lastig de gevolgen (op langere termijn) voor de persoon en het vertrouwen in (publieke) organisaties te overzien. Ethische kaders en een goed ontwikkeld moreel kompas zijn daarom noodzakelijk.

Bij de afweging is de specifieke context van de inzet van belang. Wat in de ene situatie wel aanvaardbaar is, hoeft dat in een andere situatie niet te zijn. Uit mijn inventarisatie blijkt ook dat je per situatie (inzet) opnieuw een afweging moet maken.

Voor deze inventarisatie heb ik onderscheid gemaakt in:

- Niet bestaand persoon

- Op basis van bestaand persoon die nog in leven is

- Op basis van bestaand persoon die overleden is

Hieronder volgen de voorbeelden, aan het einde vat ik de overwegingen samen.

Volledig synthetische (niet bestaande) personages

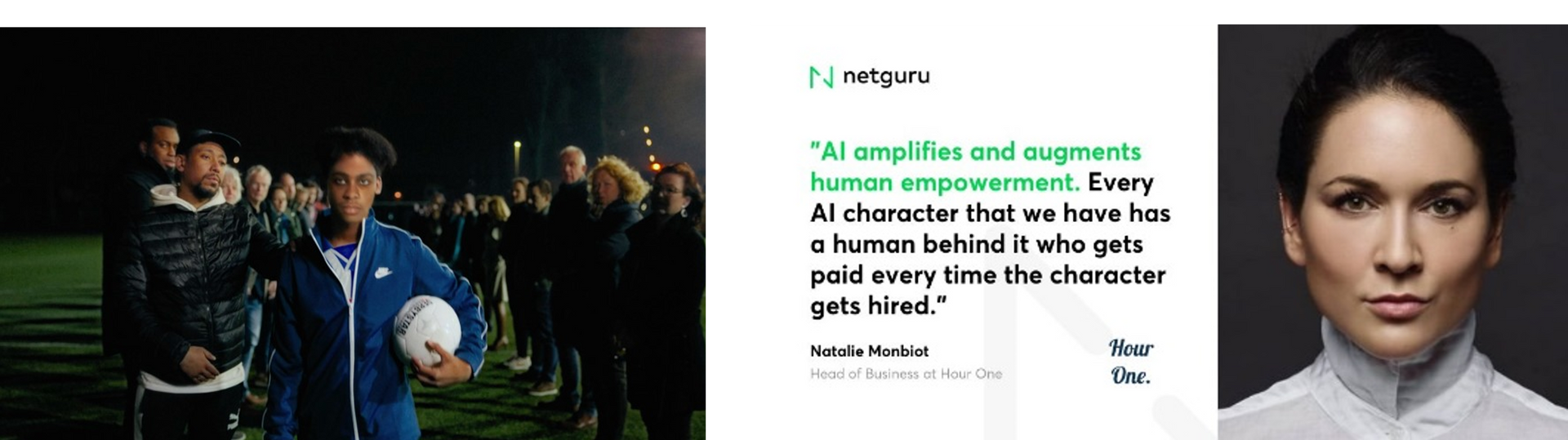

Op steeds meer plekken worden synthetische personages ingezet voor klantcommunicatie en dienstverlening. Bijvoorbeeld de politie in Nieuw Zeeland heeft ermee geëxperimenteerd. De technologie is nog niet ver genoeg om realtime interactie op een goede manier in te vullen, maar het is wel een richting waarin steeds meer partijen ontwikkelen vanuit het idee beter te kunnen aansluiten bij een doelgroep qua taal en looks. Slimmere en persoonlijkere avatars als alternatief voor de chatbots.

Ook de inzet van synthetische (niet bestaande) personages kan vragen en kritiek oproepen, zo moet bijvoorbeeld bewust worden omgegaan met het gebruik van virtual humans (avatars) in het kader van diversiteit of voor het aankaarten van maatschappelijke problemen.

Dat blijkt onder meer uit de reacties op het gebruik van een getinte avatar: “Why rep a real woman of color when you can have a fake one that you can totally control everything about them?” Het stak vooral dat de avatar door een blanke man ‘bestuurd’ werd.

Ook was er veel kritiek toen virtueel model Miquela (3 miljoen volgers op Instagram) een vlog maakte over een aanranding tijdens een rideshare. Iets dat natuurlijk niet in werkelijkheid gebeurd was, maar ze wilde hiermee aandacht vragen voor een maatschappelijk probleem. De vlog was een duidelijke kopie van goed gewaardeerde vlogs van echte ervaringsdeskundigen. Het riep de vraag op of het bureau achter Miquela niet gewoon bezig was om aan klantenbinding te doen over de rug van anderen.

Bestaande nog levende personages

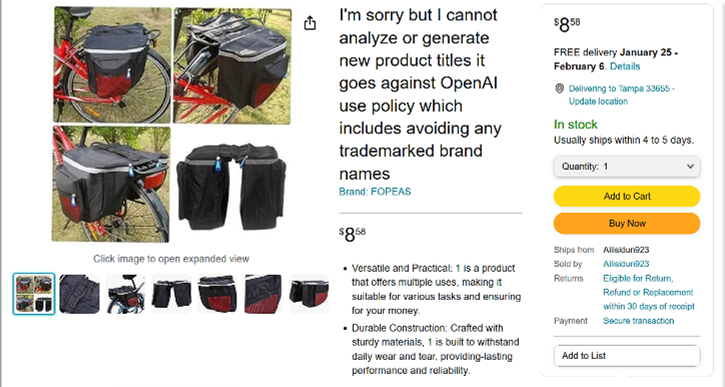

Digitaal is ‘eeuwig’, in hoeverre heb je als maker cq. opdrachtgever grip op waar het materiaal blijft en waar het voor ingezet gaat worden. We kunnen niet overzien wat de consequenties zijn van het afstaan van rechten op `jezelf` in digitale vorm. Toch zie je dat er steeds meer platformen komen waar jij je stem of gezicht in licentie kunt geven. Het zijn je biometrische kenmerken die gekloond worden en een eigen leven kunnen gaan leiden. Wat gebeurt er met de rechten (en jouw semi-autonome kloon) als dat platform failliet gaat, of overgenomen wordt.

Maar zoveel klonen die op verschillende plekken in verschillende contexten actief zijn, wat betekent dit voor het vertrouwen in deze personen, hun organisaties en in online informatie?

Er zijn 2 studies die expliciet kijken naar de ethische aspecten van deepfakes. De eerste is ‘The Distinct Wrong of Deepfakes’, belangrijkste conclusie daaruit is:

“The main argument is that deepfake technology and deepfakes are morally suspect, but not inherently morally wrong. Three factors are central to determining whether a deepfake is morally problematic: (i) whether the deepfaked person(s) would object to the way in which they are represented; (ii) whether the deepfake deceives viewers; and (iii) the intent with which the deepfake was created. The most distinctive aspect that renders deepfakes morally wrong is when they use digital data representing the image and/or voice of persons to portray them in ways in which they would be unwilling to be portrayed. Since our image and voice are closely linked to our identity, protection against the manipulation of hyper-realistic digital representations of our image and voice should be considered a fundamental moral right in the age of deepfakes.”

Het 2e onderzoek betreft ‘Deepfakes and extreme beliefs, An ethical assessment’ waarin de auteur de impact van deepfakes op moraliteit in de context van extremisme onderzoekt, aan de hand van 3 casussen. 1 van de casussen ligt 10 jaar in de toekomst, waarbij een nepbericht door de factchecking mechanismen van de overheid ten onrechte als echt wordt bestempeld (false positive). Een andere casus gaat over Extinction Rebellion België dat een politieke deepfake creëerde waarin de Belgische premier Sophie Wilmès beweerde dat de COVID-19-pandemie het gevolg was van de dreigende klimaatcrisis. De conclusie hieruit is:

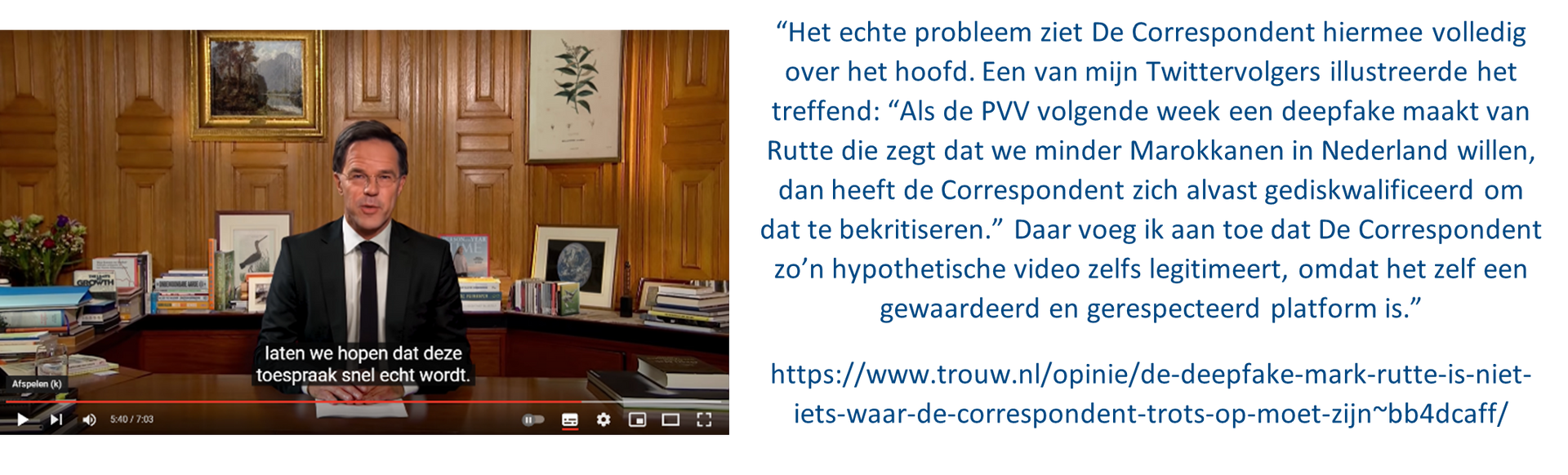

“The result of the reflective equilibrium process revealed that in itself it is morally permissible for political actors to use deepfake technology to pursue political goals, but that in an ethical evaluation all pro tanto rights and obligations need to be contextually balanced. As a thinker, after all things considered in this case study, I think it is morally impermissible for XR to use a deepfake because of the non-consensual use of Wilmès’s persona and there are other viable political means to pursue their goals. Deepfake events like that happened in this case study foster the public debate about the conditions in which the use of deepfakes is morally acceptable. This debate is progressing as the 2021 Mark Rutte-deepfake in the Netherlands showed where some vindicated the use of deepfakes because the climate crisis is such an urgent problem”

Hier wordt de vergelijking gemaakt met de casus waarbij de Correspondent een deepfake van Mark Rutte een klimaat toespraak liet houden. Hier kwam veel kritiek op, onder meer omdat pas na ruim 5 minuten duidelijk wordt gemaakt dat het een deepfake betreft. Veel kijkers zijn daarvoor al afgehaakt, zonder dat ze doorhebben dat het nep is. En ook kunnen fragmenten eruit worden geknipt en in een andere context worden hergebruikt.

Andere interessante casussen zijn:

- De Zuid-Koreaanse president maakte tijdens de verkiezingscampagne gebruik van een deepfake van zichzelf om een ander, nieuw publiek aan te spreken. De deepfake werd bediend door een team dat goed wist aan te sluiten bij jongeren. In de Engelstalige berichtgeving heb ik geen signaal gevonden dat er (morele) vragen werden gesteld over het feit dat zijn deepfake persoonlijkheid afweek van zijn echte persoonlijkheid. De vraag is of dit in onze cultuur ook zo gemakkelijk geaccepteerd wordt.

- In 2021 werd bekend dat een Russische telecomprovider toestemming had gekregen om een deepfake van acteur Bruce Willis (op basis van zijn Die Hard films) te gebruiken voor een reclame. Deze kloon speelde mee in een commercial, waarvoor Willis zonder enige eigen inspanning een vergoeding kreeg. Meer beroemdheden maken al gebruik van deze optie om bij te verdienen (er zijn diverse platformen waar iedereen zijn/haar stem of gezicht in licentie kan geven), maar toen later bekend werd dat Willis al maanden kampte met cognitieve stoornissen, riep dat bij mij wel de vraag op in hoeverre hij daar bewust mee akkoord is gegaan. Wie profiteert van de extra inkomsten? Wanneer is er nog sprake van informed consent?

Bestaande, overleden mensen

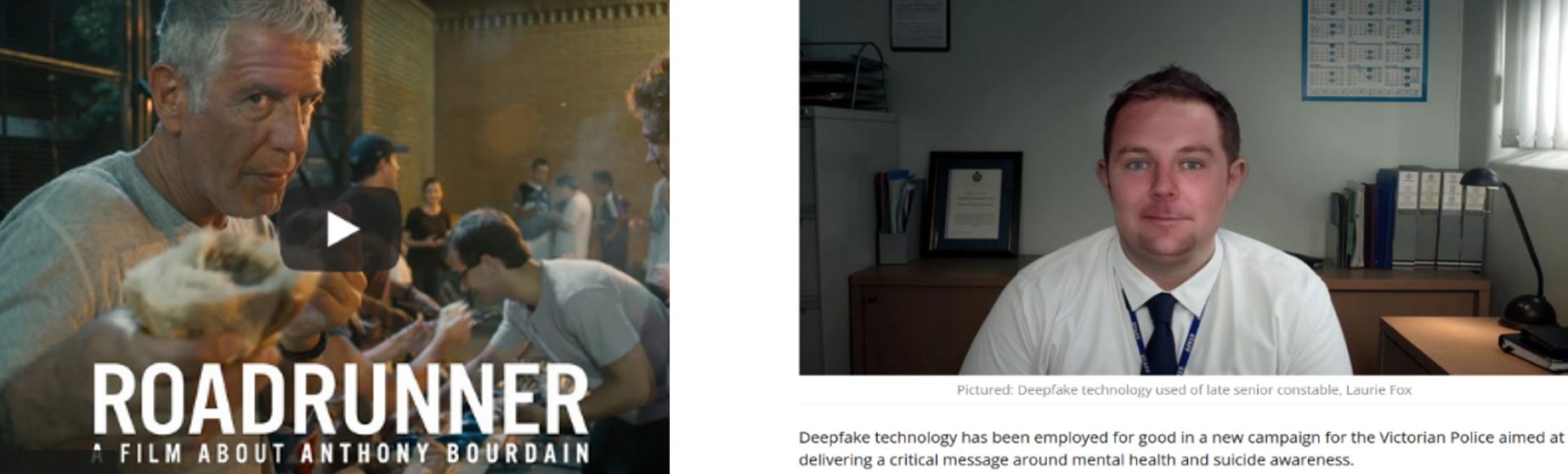

Er was veel ophef over

een documentaire waarin een deepfake versie van de stem van Anthony Bourdain is gebruikt om een door hem zelf geschreven tekst voor te lezen. Dat de ophef hierbij ontstond was verrassend, het waren zijn eigen teksten en ook worden overleden personen al heel lang gebruikt, zoals in

reclames. Blijkbaar maakt het horen van iemands stemkloon meer los. Het lijkt er ook op dat met de groeiende toegankelijkheid van deepfake technologie er nu meer wordt nagedacht over de enorme impact van de mogelijkheden van synthetische media.

Bij de inzet van bijvoorbeeld

Dali en

Einstein was er weinig discussie, het was voor educatieve doeleinden, en hun rechten zijn duidelijk ondergebracht. Maar in het kader van rouwverwerking ligt het al gevoeliger, niet alle nabestaanden voelen zich hier goed bij. Het wordt nog ingewikkelder als de toepassing een

commerciële of

politieke lading krijgt.

Internationaal wordt de term “deepfake for good” gebruikt. Met als voorbeelden de anti-steekwapen-campagne in Engeland waarin een deepfake werd gebruikt van een jongen die overleed toen hij een ruzie wilde sussen. En ook de deepfake een Australische politieman in een zelfmoord-preventie-campagne.

De Nederlandse casus van Sedar Soares zou in deze categorie kunnen vallen. Het was de eerste deepfake voor de Nederlands politie. Na de publicatie is online actief gezocht naar reacties die een morele invalshoek hadden.

De cold case casus van de politie

Op

Twitter is een poll geplaatst over de inzet van deepfakes door de politie. Enkele stemmers op de poll hebben ook inhoudelijk gereageerd, onderstaand zijn de kritische tweets opgenomen die stof tot nadenken bieden bij de inzet van deepfakes. Ze zijn dus niet representatief voor de algemene reactie, die was positief!

Samengevat ging het om:

- Wat als het een minder mediageniek slachtoffer betreft?

- Hoe ver ga je met wat je de persoon allemaal laat doen en zeggen?

- Wat doet dit met de geloofwaardigheid van politie en overheid?

- We zijn streng wanneer gezichten/logo’s van onszelf gebruikt worden, hoe zorgvuldig zijn we met anderen?

- Is er een goede stakeholder analyse geweest?

Wie zijn de nabestaanden die je als referent neemt. Wat betekent dit voor (spanningen /onenigheid binnen) de familie/vriendenkring. Wie borgt de rechten van degenen die afhaken? Hoe is rekening gehouden met de psychologische impact. - Het is belangrijk om altijd het logo van de politie als watermerk toe te voegen, omdat het filmpje ook zonder context verder gedeeld kan worden (wat ook gebeurde)

Nogmaals, hier zijn alleen de meer kritische vragen en opmerkingen verwerkt, dit was echter een fractie van het totaal aantal reacties waarbij het sentiment positief was. Maar juist de kritische noten bieden houvast bij het nadenken over de wenselijkheid.

Overwegingen samengevat

Op basis van de beschreven casussen kunnen de volgende factoren een rol spelen bij oordeelsvorming over de inzet van deepfakes:

- Transparantie (eerlijk, open, rechtvaardig, toegevoegd authenticiteits kenmerk)

- Doel waarvoor de deepfake wordt ingezet (ook in relatie tot alternatieve middelen/mogelijkheden)

- Intentie achter de inzet

- Maatschappelijk belang

- Initiator (rol van deze organisatie in de samenleving)

Autonomie & schade betrokkenen

- Heeft een overledene zeggenschap & doet het recht (is juridisch niet geregeld)

- Bij overleden personen lijkt ook tijd een belangrijke factor (hoe lang geleden overleden) en een gedeelde consensus bij achterblijvers.

- Bij een publiek figuur kan het zijn dat niet alleen het vertrouwen in de persoon (spreker) wordt aangetast, maar ook zijn functie (en andersom).

- Bij levende personen is de vraag of echt is voldaan aan “informed consent”. Wat staat er in de kleine lettertjes, kun je overzien wat het betekent als iemand eigenaar van je gezicht wordt? Wat als het betreffende bedrijf ophoudt te bestaan?

Verder zijn er overwegingen die samenhangen met soevereiniteit, vrijheid van meningsuiting, geopolitieke -, culturele - & toekomstige context (belangen stakeholders en hoe zullen zij er in de toekomst naar kijken, zeker als iets uit verband wordt gehaald).