Rijksbrede werkconferentie over de impact van synthetische media

31 januari 2023

Achtergrondinformatie bij rijksbrede werkconferentie

Op 26 januari 2023 vond de eerste rijksbrede werkconferentie plaats over de impact van synthetische media & deepfakes. Naast het plenaire deel waren er kennissessies en werd aan werktafels verdiept op diverse vraagstukken. Hieronder wordt algemene documentatie gedeeld die voor en achteraf is gedeeld in de context van de werktafels. De verslagen en presentaties zijn inmiddels gedeeld op deze pagina.

Documentatie

Kennis nationaal

- Rathenau (2020) – Digitale dreigingen voor de democratie

- Considerati (2021) - Regulering van immersieve technologieën

- WOCD (2021) - Deepfakes - De juridische uitdagingen van een synthetische samenleving, uitgevoerd door TILT in opdracht van het WODC

Kennis internationaal

- UNICRI (2020) - Malicious Uses and Abuses of Artificial Intelligence

- EPRS (2021) - Tackling deepfakes in European Policy

- ENLETS (2021) - Synthetic Reality & deep fakes impact on police work

- Europol (2022) – Facing reality? Law Enforcement And The Challenge Of Deepfakes

- Mania, Karolina (December 2022).

Legal Protection of Revenge and Deepfake Porn Victims in the European Union: Findings From a Comparative Legal Study. Trauma, Violence, & Abuse, 24 December, pp. 1-13

‘Democratische vrijheid van gedachtenvorming’

- Ons nieuwe desinformatie beleid: Kamerbrief over rijksbrede strategie effectieve aanpak van desinformatie Kamerstuk Rijksoverheid.nl

- Rapport IViR naar juridische kader desinformatie: Nieuw rapport over het juridisch kader voor de verspreiding van desinformatie - IVIR

- Een veilig publiek debat, rapportage van College voor de Rechten van de Mens

Dialoog & ethiek

- Overzicht van morele vragen bij de inzet van deepfakes

- VU (2021) -

Deepfakes and extreme beliefs door Jack Esselink

- The Distinct Wrong of Deepfakes

van Adriënne de Ruiter

Provenance

- 2022: To battle deepfakes, our technologies must track their transformations

- Content Authenticity Initiative

- Open-source tools for content authenticity and provenance

- Witness.org &

How do we work together to detect AI-manipulated media?

Metaverse

- Wat is de metaverse kort artikel waarin de terugkerende kenmerken van visies op de metaverse worden toegelicht.

- What is the metaverse uitgelegd in 14min door Mathew Ball

- toelichting op zeer

persoonlijke, privacy gevoelige gegevens die in Virtual Reality (metaverse) over je bekend worden.

Samenwerking in de keten

- (2023) Hoe stoppen wet- en regelgeving de digitale opmars van deepfakes? Toelichting door Evert Stamhuis

- (2020) Digital Forensics, deepfakes and the legal process van Agnes Venema en Zeno Geradts

- (2022) The deepfake problem:

Developing a novel maturity model for forensic image authentication research

Van Content naar Context

- (2022) Digital history and born-digital archives: the importance of forensic methods

- Meer over trust ankers in deze blogs (klik door op naam voor meer artikelen)

- Koninklijke Bibliotheek: context meenemen bij digital-native collecties.

Presentatie over LLM's bij SensemakersAMS

Afgelopen maanden mocht ik weer diverse workshops over Generatieve AI verzorgen bij een verscheidenheid aan organisaties. Altijd maatwerk, maar hieronder wat tips die voor iedereen nuttig zijn. De focus is op beelden. Generatieve AI (GenAI) Met GenAI kun je teksten, audio en beelden op maat laten genereren of bestaand materiaal manipuleren. Voor de herkenning is het handig om bij beelden onderscheid te maken tussen: Specifieke GenAI, zoals de traditionele deepfakes, waarbij het systeem bijvoorbeeld specifiek op gezichten is getraind en in een afbeelding of (live) video het gezicht kan vervangen door het gezicht van iemand anders (faceswap). Of alleen de lippen kan laten bewegen (lipsync) om de persoon op natuurlijke wijze te laten zeggen wat jij wilt. De oorspronkelijke omgeving blijft hierbij behouden, waardoor je minder aanknopingspunten hebt. De huidige detectietools zijn specifiek op het herkennen van dit soort deepfakes getraind. Maar omdat ze onvoldoende betrouwbaar zijn zul je zelf aanvullend technisch en contextueel onderzoek moeten doen (tips hieronder). Generieke GenAI, hierbij is het systeem getraind op allerlei soorten tekst, audio en video en kan het daardoor plaatjes genereren over elk onderwerp. En video en audio combineren. Je kunt aan het systeem vragen wat je wilt hebben via de prompt . Doordat ook de omgeving met AI is gemaakt, heb je meer aanknopingspunten. En omdat bij elke prompt het plaatje vanaf nul opnieuw gegenereerd wordt, is het resultaat van 2 prompts waarin een realistisch resultaat wordt gevraagd nooit exact hetzelfde.

Iedereen die me kent weet dat ik me druk maak over alle apps die mensen gebruiken en wat er aan data mee verzameld wordt. Ook weten jullie vast hoeveel moeite het kost om die zorg over te brengen. Het is immers zo makkelijk zo’n app en wat kunnen ze nou met die data... Heel veel, zoals we de laatste jaren in Amerika hebben gezien, en dan heb ik het niet over wijzigingen in je verzekeringspremie omdat de data die je auto over je verzamelt zonder dat je het weet gedeeld wordt. Nu ik het toch over de auto heb, eind 2024 werd bekend dat de gegevens die Volkswagen verzamelt (ook van Nederlanders) onveilig opgeslagen stonden, waaronder je persoonlijke gegevens en tot op 10cm nauwkeurig waar je wanneer was. Volgens hun voorwaarden hadden ze die sowieso kunnen delen met derden dus eigenlijk niks aan de hand. Maar weet je wat ze allemaal uit deze data (beweren te) kunnen afleiden? Volgens onderzoek van Mozilla : “Popular global brands — including BMW , Ford , Toyota , Tesla , Kia , and Subaru — can collect deeply personal data such as sexual activity, immigration status, race, facial expressions, weight, health and genetic information, and where you drive…. Brands can then share or sell this data to third parties." Waar ik me druk om maak is de impact hiervan op onze grondrechten, onze vrijheid, veiligheid en democratie. In 2023 kwam naar buiten dat een katholieke groepering data van de dating app Grindr kocht om te achterhalen welke priesters mogelijk homoseksueel zijn. Al in 2022 kwam naar buiten dat databrokers data verkochten waarmee je mensen kunt tracken die een planned parenthood of abortuskliniek bezoeken. Worden sinds zeker 2016 dergelijke data gebruikt om mensen online te targeten, nu kun je ze overal ook fysiek targeten, omdat je weet waar ze vandaan kwamen en waar ze na afloop naartoe gaan. Onderzoek van BNR toonde al aan dat hetzelfde geldt voor Nederlanders dankzij die leuke en makkelijke Apps. Dit zijn slechts enkele voorbeelden, maar ze laten zien hoe makkelijk het is geworden om andersdenkenden in beeld te krijgen, te isoleren en te targeten in welke vorm dan ook. Toen een paar weken terug bekend werd dat Musk de controle over allerlei overheidsinstanties overnam en illegaal een kopie van de gegevens van alle overheidsmedewerkers liet maken, werd ik letterlijk misselijk en moest ik denken aan hoe ons bevolkingsregister in de 2e wereldoorlog misbruikt werd. Voor sommigen lijkt dit misschien extreem, maar ik volg de ontwikkelingen van (online) targeting, uitsluiting en discriminatie al veel langer, dat ik werk bij de politie komt omdat ik echt geloof in de waarden van onze rechtstaat. Lang snapte ik niet waarom, naast gericht targeten, het ook ging om simpelweg kapot maken. De Russen waren heel transparant over hun informatie oorlog; “what it basically means is to change the perception of reality of every American to such an extent that despite the abundance of information, no-one is able to come to sensible conclusions in the interest of defending themselves, their families, their community and their country.” Overgelopen KGB-officier Yuri Bezmenov in 1984 Maar waarom dit ook vanuit het westen gebeurde, waar we het zo goed hebben? Het kwartje viel toen ik de documentaire zag met Trump-fluisteraar Steve Bannon; het doel is echt om het bestaande compleet te vernietigen, omdat je zo de door hen gewenste samenleving vanuit het niets kunt opbouwen. Na het bevel om mensen met een niet hetero geaardheid te ontslaan kwam ook de oproep om elkaar vooral te verlinken, anders kon je een negatieve beoordeling krijgen. Dat nu ook alle personeelsgegevens in handen zijn van iemand die duidelijk op heksenjacht is, is niet gewoon zorgelijk, maar fundamenteel gevaarlijk. Zeker nu blijkt dat er ook banden zijn met Peter Thiel, een van de grootste ondernemers op het gebied van data analyse en iemand die zich duidelijk uitspreekt tegen de democratie. Het is zo simpel, combineer de gegevens uit voertuigen met die van overheidsmedewerkers en je kunt ze indelen in groepjes waar je tegen bent. Misschien dat velen nog steeds denken dat het hen niet aangaat, dat dit om Amerika gaat of dat jij niet in zo’n groep valt. Allereerst is het goed te weten dat er ook in Europa en Nederland mensen zijn die dit gedachtengoed ondersteunen. En dat, ondanks dat we met Europese regelgeving veel beter beschermd zijn, er toch ook veel informatie over jou beschikbaar is bij de datahandelaren en in onveilige (Amerikaanse) cloudomgevingen. Weet jij wat er gebeurt met de data die jouw Samsung, LG of andere 'slimme' televisie verzamelt? Welke conclusies ze daaruit trekken over jouw zijn en met wie ze dit delen? Bij gebruik geef je nagenoeg altijd goedkeuring op voorwaarden waarin staat dit mag: “analyzing the use and effectiveness of [their] services,” and “developing [their] business and marketing strategies.” En “their” staat dan voor elk andere organisatie waar zij een link mee (willen) hebben... En mocht je denken “gelukkig, ik zit niet in hun doelgroep”. Weet dan dat je altijd wel in iemands doelgroep zit , en dat deze mensen blind vertrouwen op AI en data, ook als er geen wetenschappelijke onderbouwing is. Jij weet niet waarom jouw auto een conclusie trekt over jouw sexuele geaardheid. Maar voor hen wordt dat de waarheid! Wat ik eigenlijk wil zeggen: Stem bewust bij verkiezingen Wees je bewust dat gemak een hoge prijs heeft. Jij kunt nu niet overzien welke conclusies die slimme apparaten, apps en platformen trekken over jouw mentale gezondheid, sexuele geaardheid en meer. En al helemaal niet wat de consequenties hiervan zijn voor jou persoonlijk, je dierbaren en onze samenleving. (Europese) overheden horen niet thuis op dergelijke platformen Het lijkt alsof de meeste overheidsorganisaties nog steeds als uitgangpunt hanteren dat daar waar veel Nederlanders zitten, ook zij aanwezig moeten zijn. Maar met je aanwezigheid steun je impliciet het platform, je accepteert het als ruimte binnen de Nederlandse samenleving waar je een rol wilt hebben, je associeert je ermee. Dat terwijl je de veiligheid er niet kunt waarborgen, je geen idee hebt wie met welke informatie/gesprekken kan meekijken, wat er met de data van/over mensen gebeurt en wat dit betekent voor de profielen die over mensen samengesteld worden... Is het bijvoorbeeld wel verantwoord dat de AIVD haar vacatures deelt op LinkedIn waardoor bijvoorbeeld Amerikanen precies kunnen weten wie (interesse heeft in) solliciteren bij de AIVD? Met onze aanwezigheid op platformen, helpen wij hen met het verzamelen van meer data over mensen in onze samenleving. Het plaatje hieronder laat als voorbeeld zien welke conclusies men denkt te kunnen trekken op basis van informatie uit je ogen. Dit kan niet alleen met een VR-bril, ook via de webcam. En we vinden dergelijke technologie niet alleen online, maar ook offline in bijvoorbeeld voertuigen .

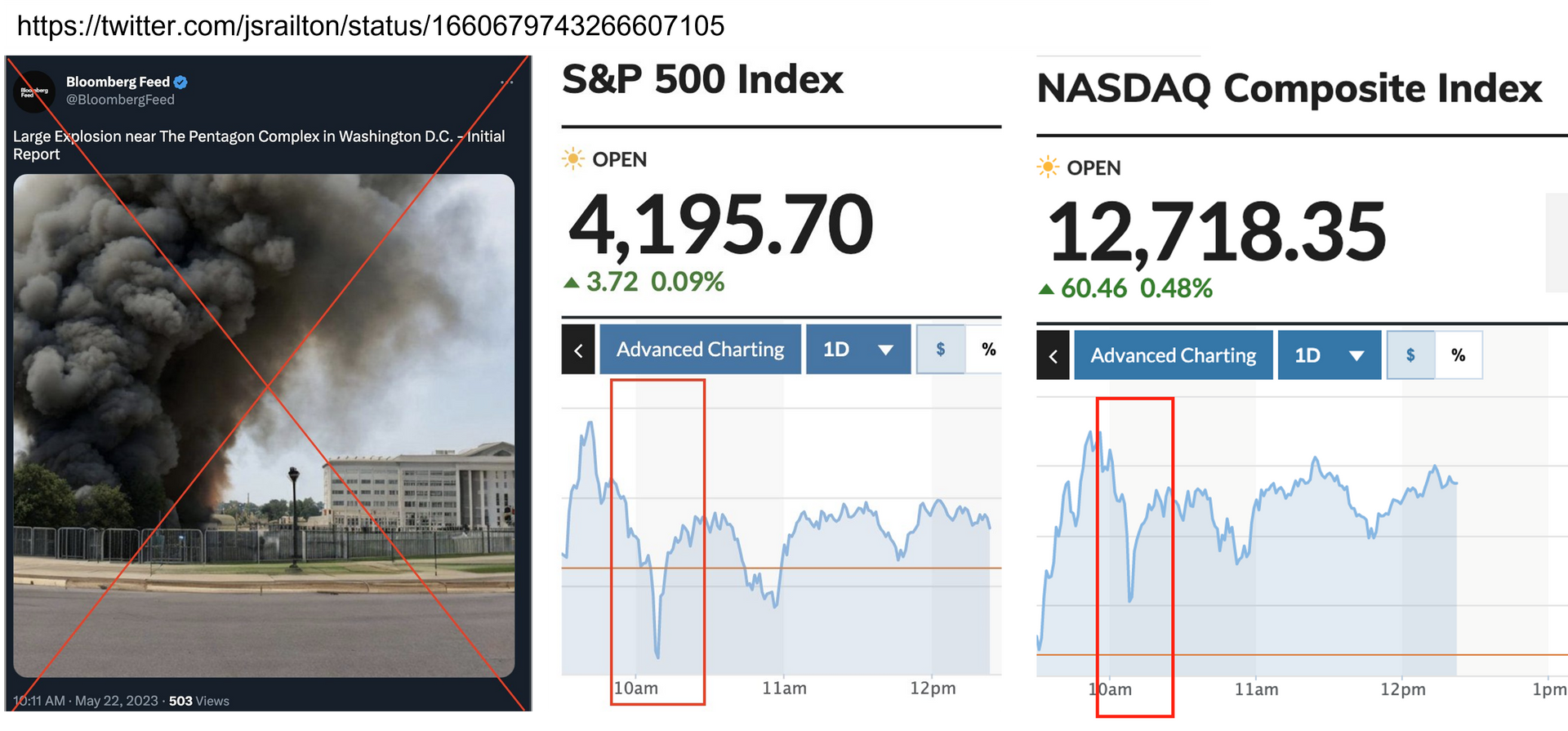

Het is even geleden dat een update geplaatst werd, schandalig want de ontwikkelingen buitelden over elkaar heen afgelopen jaar. Werd vorig jaar nog vooral gesproken over deepfakes (beeld/geluid) en synthetische media, sinds dit jaar zien we overal de term generative AI en tools voor het genereren van tekst, zoals ChatGPT. Hoewel er bijna dagelijks nieuwe mogelijkheden verschijnen, blijft de grote lijn hetzelfde. (1) Iedereen kan straks alles wat digitaal (te maken) is klonen, manipuleren en/of genereren en (2) al rond 2025 is naar verwachting 90% van alle digitale content synthetisch, dus met AI gemanipuleerd of gegenereerd. Dit zal een enorme impact hebben. We kunnen niet meer vertrouwen op onze eigen waarneming. Hoe weet je in welke mate je gemanipuleerd wordt, hoe behoud je vertrouwen? Hierover ging de eerste, door politie geïnitieerde, rijksbrede werkconferentie “impact van synthetische media & deepfakes”. Op iBestuur is recent een blog geplaatst met belangrijkste stappen die we kunnen zetten. In deze nieuwsbrief heb ik de nieuwtjes gegroepeerd in beeld, geluid (stemklonen!) en tekst. Door deze te combineren kun je er volledig autonome digitale personages (avatars) mee creëren en voor je laten werken. Ter afsluiting ook nog iets over detectietools. Beeld Er is een duidelijke toename van beeldmateriaal van kindermisbruik gecreëerd met AI tools . Op TikTok worden in true crime stories, steeds vaker deepfakes van slachtoffers , vooral kinderen, gebruikt, wat enorme impact op betrokkenen kan hebben. Het genereren van afbeeldingen ter ondersteuning van je verhaal kan ook ten koste gaan van je geloofwaardigheid zoals Amnesty mocht ervaren. Het vooraf transparant aangeven dat en waarom je ervoor kiest (zoals beschermen betrokkenen) helpt. Een overzicht van overwegingen bij de inzet van deepfakes vind je hier . Een gegenereerde foto van een explosie bij het Pentagon getwitterd door een schijnbaar betrouwbaar account van Bloomberg zorgde voor een dip in de beurzen. • De schroom om deepfake beelden te gebruiken voor politieke doeleinden verdwijnt steeds verder. De Republikeinse presidentskandidaat DeSantis heeft er geen enkele moeite mee om deepfake beelden van zijn rivaal Trump te verspreiden (die er zelf ook gretig gebruik van maakt). Steeds vaker worden video’s met niet bestaande personen (avatars) ingezet voor het verspreiden van desinformatie, ook door overheden, bijvoorbeeld in Burkina Fasou en Venezuela . Mooie voorbeelden van de laatste mogelijkheden van beeldbewerking zijn DragGan en de opties die Adobe nu biedt. Audio Er komen steeds meer toepassingen waarbij je jouw stemkloon kunt inzetten, Microsoft heeft aangetoond dat 3 seconden geluid voldoende is. In dit artikel worden 11 tools beschreven. Gek genoeg staat Elevenlabs hier niet bij, terwijl zij juist zoveel misbruikt werden, bijvoorbeeld om de stem van Emma Watson uit Mein Kampf te laten voorlezen. Denk dus na voor je iets op TikTok plaatst, een fragment van je stem is voldoende om te klonen. Hier een voorbeeld van hoe je er persoonlijke gegevens mee kunt ontfutselen. We zien dit ook steeds meer terugkomen bij verschillende vormen van CEO en Vriend-in-Nood-Fraude toegepast worden. Er kan ook emotie aan de stemkloon meegegeven worden, zo werd deze moeder overtuigd dat haar dochter ontvoerd was. Het wordt extra effectief met een combinatie van gezicht en stem… In deze post heb ik wat tips opgenomen waarmee je kunt voorkomen erin te trappen. Steeds meer organisaties zijn overgestapt op biometrische authenticatie, en zij lopen er nu tegenaan dat dit hun systeem verzwakt. Al veel langer is het mogelijk om met het gezicht van iemand anders een bankrekening te openen. Banken, maar ook andere organisaties zoals de belastingdienst in Australië , gebruiken ook de stem als biometrische controle voordat ze iemand toegang geven. Vice laat zien dat deze systemen niet bestand zijn tegen stemklonen. Swatting as a service , een dienst die opnames met nepstemmen aanbiedt die je kunt inzetten om de politie ergens een inval te laten doen. $50 om je school een dagje plat te leggen, en voor $75, laat je ze iemands huis binnenvallen en doorzoeken… Zeer zorgelijk gezien de politiecapaciteit die hiermee verspild wordt en de emotionele impact op betrokkenen. Samsung kondigde recent de mogelijkheid aan om via tekst-to-speech je stemkloon een gesprek in stilte te laten voeren als je ergens bent waar je niet kunt praten. Koppel het aan toepassingen als ChatGPT en je hoeft helemaal het gesprek niet meer te voeren😉 Tekstsynthese (Large Language Models, ChatGPT) Tekstmodellen kunnen op veel manieren ondersteunen en brengen eindeloos veel nieuwe mogelijkheden voor mensen die ergens leek in zijn of minder taalvaardig. Neem dit voorbeeld voor het ontwerpen van een tomatenpluk-machine , of hoe ChatGPT je kan helpen in een live sollicitatie gesprek . Als je echt een goed beeld wilt krijgen van de betekenis (het grotere plaatje), dan raad ik de podcast The AI Dilemma aan, beste dat ik afgelopen tijd hoorde! Het gaat vaak mis met ChatGPT en vergelijkbare tools. Mensen willen het gebruiken als zoekmachine, maar het is ontwikkeld om voor jou teksten te genereren, dus als jij bronnen wilt hebben, dan krijg je die, maar die hoeven niet echt te bestaan zoals deze advocaat merkte toen hij jurisprudentie zocht. Mensen kunnen er ook echt door beschadigd worden. Zoals een burgemeester ervaarde, die volgens ChatGPT in de gevangenis had gezeten, of de man die geld verduisterd zou hebben en de professor zogenaamd betrokken bij sexueel misbruik . Als mensen naar je gaan zoeken via ChatGPT, kunnen de gekste dingen opkomen. Spannend wordt of het lukt om OpenAI, het bedrijf achter ChatGPT aan te klagen… Voor wie het toch wil gebruiken vast een tip, hoe overtuigender het antwoord van AI, hoe groter de kans dat het niet klopt ! Door het combineren van de mogelijkheden van deepfake audio en video met ChatGPT die de gesprekken genereert, kun je (semi) autonome personages (avatars/digital humans) creëren die aan de hand van een aantal mee gegeven intenties zelf gesprekken en relaties aangaan en aan hun handelen invulling geven. Zo kun je een kloon van je zelf tegen vergoeding beschikbaar stellen, bijvoorbeeld als virtuele vriendin . In de praktijk blijkt het echter lastig af te bakenen hoe ver jouw kloon mag gaan… In dit artikel meer commerciële toepassingen (denk aan dienstverlening, trainingen) en diverse dreigingen. Ook kun je (meerdere) avatars autonoom aan het werk zetten in de metaverse. Dit werk kan echter ook inhouden het verspreiden van gedachtengoed en ronselen van mensen… Hier een voorbeeld van de eerste experimenten met volledig autonome “mensen” in een “metaverse” die zelf op basis van intentie hun activiteiten en doelen van de dag bepalen en op basis daarvan onderling interacteren. Er is een aparte nieuwsbrief over de Metaverse, laat het me weten als je die wilt ontvangen! AI-detectietools Met de opkomst van AI groeit ook de vraag naar AI-detectietools, ik heb bewust geen overzicht opgenomen, want ze vormen ook een risico als we erop gaan vertrouwen (en weet je wie achter de tools zitten, dus met wie je tekst/beeld deelt?). Van deepfake-detectietools is bekend dat ze niet goed werken. Ze detecteren maar een deel van de fakes en ze merken soms ook betrouwbare content aan als fake. Ook laat recent onderzoek naar detectietools voor door studenten met AI-gegenereerde tekst zien dat deze een bias kennen naar non-native Engelssprekenden. Hun werk wordt veel vaker als AI-generated (“fake”) aangemerkt dan dat van native sprekers. Als in 2027 90% van de content met AI gegenereerd of gemanipuleerd is, vraag ik me ook af wat de meerwaarde is van het weten dat AI gebruikt is? Het gaat uiteindelijk om wat je met de informatie wilt doen, dat bepaalt de relevantie van de manipulaties… Onderzoek daarom zelf in welke context de informatie gegenereerd is en toets dat aan de context waarin jij het wilt toepassen. Wat gaat helpen zijn de initiatieven op het gebied van provenance, internationaal zijn grote consortia van camerabedrijven, nieuwsmedia (oa BBC), Google, Microsoft, Adobe, Truepic en vele anderen hiermee bezig. Ook op de rijksbrede werkconferentie werd dit als een belangrijke oplossingsrichting gezien. Wil je meer weten over provenance, bekijk dan deze toelichting . Heb je vragen, zelf interessante links, laat het me weten via het contactformulier!

De grootste maatschappelijke impact van deepfakes (en eigenlijk de synthetisering van media in het algemeen) is dat als steeds meer nep wordt, het vertrouwen in informatie en daarmee in potentie in de rechtstaat wordt ondermijnd. Zoals experts aangeven : " deepfakes generate and justify false beliefs” & “may prevent people from acquiring true beliefs." De kosten voor het verifiëren van informatie nemen toe, zowel voor organisaties als individuen. Door deze ondermijnende impact op het vertrouwen in de informatie(voorziening) is, ook als iets kan en mag, de belangrijkste vraag: “wat vinden we wel en ni et moreel aanvaardbaar als het gaat om de inzet van deepfake technologie”? Dit moet niet alleen vanuit het individuele/organisatieperspectief bekeken worden, maar ook vanuit het bredere perspectief van de samenleving. Het ‘perspectief van de samenleving’, is echter een vaag begrip, daarom ben ik online op zoek gegaan naar wat mensen bezighoudt als het gaat om inzet van deepfakes. Dus geen wetenschappelijk onderzoek, maar het biedt duidelijk haakjes voor vragen die je jezelf en anderen kunt stellen. Het zal ook niet volledig zijn, dus laat het vooral weten als je andere, aanvullende inzichten hebt opgedaan! Onderaan deze blog vind je een optie voor contact. Ethisch perspectief Vanwege de maatschappelijke impact van deepfakes wordt vaak gewaarschuwd tegen het normaliseren van het gebruik, zeker als het gaat om het klonen van bestaande mensen. Regelgeving ontbreekt als het gaat om post mortem privacy, en ook is het lastig de gevolgen (op langere termijn) voor de persoon en het vertrouwen in (publieke) organisaties te overzien. Ethische kaders en een goed ontwikkeld moreel kompas zijn daarom noodzakelijk. Bij de afweging is de specifieke context van de inzet van belang. Wat in de ene situatie wel aanvaardbaar is, hoeft dat in een andere situatie niet te zijn. Uit mijn inventarisatie blijkt ook dat je per situatie (inzet) opnieuw een afweging moet maken. Voor deze inventarisatie heb ik onderscheid gemaakt in: Niet bestaand persoon Op basis van bestaand persoon die nog in leven is Op basis van bestaand persoon die overleden is Hieronder volgen de voorbeelden, aan het einde vat ik de overwegingen samen.

De documentaire Spreek! Nu! heeft vorige week veel indruk gemaakt. Door het gebruik van een deepfake van Sedar Suares, de jongen die bijna 20 jaar geleden vermoord werd, hoopt het Cold Case team mensen echt te raken en getuigen of misschien zelfs de dader te overtuigen zich te melden. Dat het gebruik van deze technologie tevens tot meer media aandacht leidt is meegenomen. Ook aan jullie het verzoek de campagne te delen, hopelijk wordt de zaak nu eindelijk opgelost. Hoewel heel beperkt, zie je dat er online ook vragen worden gesteld over de wenselijkheid om het gebruik van deepfakes van bestaande personen te normaliseren. Ik probeer zoveel mogelijk vragen/opmerkingen/zienswijzen te verzamelen om tot een overzicht te komen van morele en ethische kaders (vragen) die een rol kunnen spelen bij de inzet (naast natuurlijk juridisch). Al eerder deelde ik voorbeelden van deepfakes van overleden personen in een bl og . Mochten jullie ideeën hebben of mee willen denken over functionele behoeften en/of ethische kaders, benader me vooral! Ook verdachten (en hun advocaten) hebben inmiddels meer kennis van de mogelijkheden van deepfakes. Begin deze maand was ik in de rechtbank Rotterdam bij de behandeling van het verweer van een verdachte die claimde niet zelf een bankrekening bij Bunq geopend te hebben. In deze context is het goed kennis te hebben van het onderzoek dat Sensity vorige week publiceerde. Het beschrijft de mogelijkheden om met een zogenaamde deepfake face swap voor de webcam het, volledig geautomatiseerde, biometrische online authenticatiesysteem voor de gek te houden. De mogelijkheden zijn er dus. Maar voor de mens is er nog wel een duidelijk kwaliteitsverschil in de beelden. Bunq gebruikt bovendien een combinatie van beeld en geluid, die alleen met een nog groter kwaliteitsverschil te faken is. Hieronder nog wat opvallende nieuwtjes over de afgelopen periode: Aansluitend op de inleiding, afgelopen week kwam naar buiten dat Marvel een contract gesloten heeft met Stan Lee Entertainment (organisatie die zijn nalatenschap beheert) “to use his name, voice, likeness, and iconic signature across a wide number of applications—including, but not limited to, films and television shows, theme parks, merchandise, and undefined “experiences.” Dit artikel benadrukt hoe triest het is dat zo’n groot comic-schrijver ook na zijn dood nog uitgebuit wordt. Intel, Dell en Rolls-Royce hebben een tool gemaakt waarmee mensen hun stem veilig kunnen stellen, voordat ze deze verliezen aan bijvoorbeeld ALS. Al eerder deelde ik een video waarin acteur Val Kilmer via de computer met zijn gekloonde stem spreekt, hij speelt nu weer mee in het vervolg op Top Gun. Mooie voorbeelden van het gebruik van tekstsynthese voor poëzi e en de nieuwste versie van Dall-E . Je kunt het trouwens zelf ook uitproberen, voer de gewenste tekst in en zie wat Dall-e mini ervan maakt. Of speel met Copy.ai voor het genereren van teksten. Ook het satirische nieuwsblad De Speld gebruikte trouwens tekstsynthese (gpt3), het hielp bij het schrijven van teksten voor hun theatershow. Natuurlijk kan in dit kader een rapportage over ethische en sociale risico’s van taalmodellen (zoals GPT3) niet ontbreken. Met MyHeritage kun je niet alleen een gezicht in een foto laten bewegen, je kunt er nu ook een animatie mee maken waarbij je de personen in de foto een stem geeft om een verhaal te vertellen. Mensen van wie de stem niet overeenkomt met hun uiterlijk, zoals de transgender in dit artikel, kunnen nu een deepfake stem gebruiken in online games , om te voorkomen dat ze hiermee gepest worden. Er nieuw onderzoek tav deepfake detecti e verschenen, waarbij ze kijken naar gezichtsuitdrukkingen voor het detecteren van deepfakes. Dit zou in de bekende testsets leiden tot een score van 99%. Een mooie nieuwe invalshoek, maar goed te bedenken dat dit in een labomgeving is en dat bijvoorbeeld in sommige videoconferencing tools gezichten aan de ontvangende kant met deepfake technologie opnieuw worden gegenereerd om bandbreedte te besparen. De detector zou daarbij ten onrechte aangeven dat je met een fake-iemand in gesprek bent.

Hieronder weer een overzicht van nieuws en ontwikkelingen gerelateerd aan synthetische media. Vanwege het vertekende beeld dat de term ‘deepfakes’ geeft, zal ik het alleen nog maar hebben over synthetische versies van een stem, gezicht etc. Mede door de oorlog in Oekraïne en de desinformatie die verspreid wordt met synthetische versies van Zelensky en Poetin had het onderwerp de afgelopen periode weer de volle aandacht. Zorgelijk was het nieuws dat onderzoek uitwijst dat mensen niet alleen moeite hebben met onderscheid maken tussen echte en synthetische gezichten, maar ook nog eens de synthetische gezichten betrouwbaarder vinden. Geen wonder dat deze met AI gegenereerde foto’s veelvuldig gebruikt worden op LinkedIn. We kenden het gebruik al op Twitter in diverse desinformatie campagnes , maar op LinkedIn lijken (naast spionage of social engineering voor cybercrime) de nepprofielen ook volop ingezet te worden voor het genereren van nieuwe business . De gebruikte profielfoto’s worden (gelukkig) nog steeds vooral via de site thispersondoesnotexist.com gegenereerd. Deze maakt gebruik van verouderde technologie uit 2019, waardoor ze door detectietools herkend worden. Divers Tijdens de verkiezingscampagne maakte de Zuid Koreaanse presidentskandidaat Yoon Suk-yeol gebruik van een synthetische versie van zichzelf , waarmee hij succesvol een nieuw publiek wist aan te spreken. Meer dan 3.000 ingesproken zinnen en 20 uur audio en video werden gebruikt om de avatar te creëren. Zijn campagneteam bepaalde wat de avatar zei, daarmee goed aansluitend op de kiezers die ze wilden aantrekken, en die het blijkbaar niet erg vonden een hele andere persoonlijkheid voorgeschoteld te krijgen. Hij won de verkiezingen nipt, misschien gaf het de doorslag? De BBC Academie organiseerde eind maart de online conferentie " Trust In News " over onder andere desinformatie en deepfakes. Hierbij wordt ook ingegaan op de beperkingen van detectie technologie . In de laatste Iphone versies worden je foto’s zodanig gemanipuleerd door AI , dat mensen de camera liever niet gebruiken. Intel, Dell en Rolls-Royce hebben een tool gemaakt waarmee mensen hun stem veilig kunnen stellen, voordat ze deze verliezen aan bijvoorbeeld ALS. Het Stimuleringsfonds Creatieve Industrie heeft Yori Ettema en Parnassia Groep de gelegenheid geboden DeepMemory verder te verkennen. In deze tweede fase gaan het team een haalbaarheidsstudie doen. Het vermoeden is dat angstige mensen via het zien van een deepfake hun angsten kunnen verminderen. Tijdens de conferentie in Dubai zat ik samen met een politieman uit Nieuw Zeeland in een panel. Hij vertelde me later over hun ervaringen met Ella, Nieuw Zeelands eerste synthetische politieagent e . Het blijkt dat de chatbot technologie en spraakherkenning/synthese nog onvoldoende zijn voor spontane realtime interacties. Het werkt vooral goed in zeer gecontroleerde omstandigheden, waarbij thema's en antwoorden goed afgebakend zijn. Fijn om zo van anderen te kunnen leren! Desinformatie nieuws: Deze handreiking van BZK geeft ambtenaren en bestuurders juridische en praktische tips om de impact van desinformatie te verminderen en geeft aan wat organisaties kunnen doen als ze ermee te maken krijgen. Er is onderzoe k gedaan naar multiplatform aanpak bij informatieoperaties: pogingen om het informatie-ecosysteem te verstoren door middel van methoden zoals de verspreiding van desinformatie: Theoretically, based upon the empirical findings presented, I reconceptualize information operations as not solely the product of inauthentic coordinated behavior (orchestrated bots and trolls) but as also involving authentic (as in real, sincerely participating) actors that loosely collaborate in the production, synthesis, and mobilization of disruptive narratives that serve the strategic goals of the information operation. Methodologically, I contribute to a growing body of work in the area of disinformation and online activism that utilizes a mixed-method approach to research. And, based on my examination of a multi-platform information operation, I end with implications for social media platform policy. Een analyse van de rol van tiktok in de online oorlog tussen Oekraine & Rusland. Deel vooral voorbeelden die je zelf tegenkomt, ideeën of ervaringen. Wil je tussendoor op de hoogte blijven, volg me dan op Twitter; @Digitalks_eu

Er is weer een hoop gebeurd deze maand, het meest opvallend vond ik hoe `normaal` het klonen van jezelf om bij te verdienen wordt. Lees hier over studente Liri die een bijbaan in de horeca heeft, maar daarnaast ook nog in diverse landen bijverdient met onder andere reclames, interviews en instructievideo´s. Dit kan doordat ze de rechten op haar gezicht heeft afgestaan aan het bedrijf Hour One, die meerdere klonen in portefeuille heeft. Het roept bij mij vragen op over wenselijkheid, de kleine lettertjes, maar ook over wat er met jouw kloon gebeurt als een dergelijk bedrijf failliet gaat… Gecombineerd met tekstsynthese worden klonen steeds autonomer en je hebt geen idee wat de digitale versie van jou zegt en doet. Ethische aspecten bij deepfakes van overledenen De afgelopen maand was er veel ophef over een documentaire waarin een deepfake versie van de stem van Anthony Bourdain is gebruikt om door hem zelf geschreven teksten voor te lezen. Dat de ophef hierbij ontstond was verrassend, het waren zijn eigen teksten en ook worden overleden personen al heel lang gebruikt, zelfs in reclames . Blijkbaar maakt het horen van iemands stemkloon meer los, wellicht dringt hiermee pas de enorme impact door van de mogelijkheden van synthetische media. Het is goed dat het gesprek gevoerd wordt over de ethische dilemma’s en nodige regelgeving rondom het gebruik van overleden personen. Bij de inzet van bijvoorbeeld Dali en Einstein was er weinig discussie, het was voor educatieve doeleinden. Maar in het kader van rouwverwerking ligt het al gevoeliger, niet alle nabestaanden voelen zich hier goed bij. Het wordt nog ingewikkelder als de toepassing een commerciële of haast politieke lading krijgt, zoals de inzet van de Spaanse zangeres Lola Flores in een reclame voor bier of het gebruik van deepfakes van slachtoffers van de explosie in Libanon om gerechtigheid te vragen. Ook in Nederland ontbreekt afdoende wet- en regelgeving en is het nodig dat we het gesprek aangaan. Niet alleen in de context van post mortem privacy, ook om mensen te beschermen. We kunnen gewoon niet overzien wat de consequenties zijn van het afstaan van rechten op `jezelf` in digitale vorm. Steeds meer Deepfakes-as-a-Service Volgens Recorded Future zie je nu ook steeds meer maatwerk en handleidingen specifiek gericht op enerzijds het omzeilen van security systemen en anderzijds het automatiseren van phishing pogingen via email of op communicatieplatformen zoals Slack and Microsoft Teams. Cybercriminelen profiteren van de thuiswerktrend om medewerkers te manipuleren met goed getimede voicemailberichten van hun baas/collega, of een slack-bericht met dezelfde boodschap. Omgevingen die gebruikers impliciet vertrouwen omdat het een alternatieve werkomgeving is. In het overzichtsartikel wordt ook verwezen naar de kwetsbaarheid van biometrische verificatiesystemen. Is AI een zelfstandige entiteit? AI kan prachtige kunst maken en ook uitvindingen doen. Zou AI daarmee ook een patent kunnen aanvragen? Zowel in Zuid Afrika als in Australië is nu een patent toegekend aan een AI. Een woordvoerder van het Europese patent bureau heeft aangegeven aan dat hier nog steeds geldt dat AI vooral een instrument is, in gebruik bij de mens. Ook in de VS kunnen nog steeds alleen mensen een patent aanvragen. Divers Goed nieuws op het gebied van het waarmerken van foto’s op websites. Truepic, onderdeel van de Coalition for Content Provenance and Authenticity ( C2PA ), lanceert een software development kit (SDK) om de metadata van foto’s, op het moment dat deze gemaakt worden met de camera vanuit een app, te verifiëren inclusief tijdstempel en geolocatie. Dit artikel dat ingaat op risico’s van deepfake technologie bij militaire operaties. Enerzijds kan het gebruikt worden om deepfakes te maken waarbij krijgsgevangenen dingen zeggen die het thuisfront en/of de operatie kunnen ondermijnen, anderzijds kunnen deepfakes gebruikt worden om de mentale gesteldheid van de gevangenen te beïnvloeden. Door keelkanker verloor acteur Val Kilmer zijn stem, maar dankzij AI is hij nu weer in staat met zijn eigen stem te spreken. Luister vooral naar dit fragment over zijn creatieve ziel ie zich weer kan uiten. Er komen steeds weer nieuwe en betere tekstsynthese modellen. Wil je het een keer ervaren, ga dan in gesprek Kanye West . Onderzoekers zijn er in geslaagd zogenaamde “ Master Faces ” te creëren waarmee ze 40% van de gezichten konden imiteren uit de dataset van 3 bekende gezichtsherkenningssystemen (Dlib, FaceNet en SphereFace). Dit was mede mogelijk doordat deze dataset een grote bias had richting oudere, blanke mannen. Het laat weer zien hoe met deepfake technologie getraind kan worden op het misleiden van biometrische herkenningssystemen. Toegift In mijn masterclasses refereer ik ook naar de mogelijkheden van online microtargeting. Deepfakes kunnen als middel bijdragen aan zowel de impact als verspreiding van (des)informatie die specifiek op jou gericht is. Dit artikel van Haroon Sheikh over hoe dit ons kan beïnvloeden gaf mij weer een nieuwe invalshoek. Heb je vragen, ideeen of tips? Laat ze hieronder achter, of als je niet kunt inloggen kun je me ook op LinkedIn bereiken of via Twitter . Om deze update maandelijks in je mail te krijgen kun je een mailtje sturen naar update [apestaartje] digitalks.eu

Soms heb je een regenachtige dag nodig om al je bewaarde linkjes door te nemen. Er was weer genoeg nieuws afgelopen periode, zoals dit rapport over deepfakes voor het Europees Parlement. Naast een goed overzicht van ontwikkelingen (ook audio en tekst) schetst het 5 dimensies voor het aanpakken van de negatieve impact van deepfakes: 1. the technology dimension, 2. the creation dimension, 3. the circulation dimension, 4. the target dimension, and 5. the audience dimension. Er wordt ook gewezen op het belang van contextuele informatie en achtergrondkennis bij het beoordelen van de authenticiteit van informatie. Om een betrouwbaar beeld van de werkelijkheid te krijgen zullen zowel individuen als organisaties nieuwe vaardigheden en procedures moeten ontwikkelen. Gelukkig onderkennen steeds meer organisaties dit en groeit ook het bewustzijn dat de meerwaarde van deepfake-detectie tools zeer beperkt is. Nuttiger is deze, voor iedereen beschikbare, plugin , ontwikkeld om journalisten te helpen bij het vaststellen van de authenticiteit van content op social media. Synthetische klonen; Digital Twins De term digital twins gaat niet alleen over steden en objecten, de term wordt ook steeds vaker gebruikt voor synthetische klonen van mensen. In eerdere updates deelde ik al enkele platformen waarop mensen een deepfake kloon van hun stem of gezicht in licentie geven. Ook Bruce Willis heeft ontdekt dat hij op deze manier vanuit zijn luie stoel veel geld kan verdienen. Hier het eerste resultaat, zie jij dat het nep is? Zangeres Holly+ heeft inmiddels ook een “ AI-powered deepfake digital twin ” van haar zangstem beschikbaar gesteld. Iedereen kan nu muziek maken en haar stem daarin gebruiken. De CEO van NVIDIA ging nog een stap verder, gedurende 14 seconde van zijn presentatie op een online congres, werd hij onopgemerkt vervangen door een synthetische kloon (volledige lichaam). Als je achteraf terugkijkt zie je dat beeld en geluid niet helemaal synchroon zijn, maar dat gebeurt wel vaker tijdens online presentaties, dus als je in het verhaal zit valt dit niet op. Bescherm je (biometrische) data Verkopers op de Chinese zwarte markt bieden nu databases aan met foto's van gezichten van mensen inclusief wat persoonlijke informatie (bv telefoon en bankreknr.) voor 0,07dollar per stuk. Deze kunnen gebruikt worden voor identiteitsdiefstal. Voor 5 dollar extra krijg je er deepfake software bij waarmee je de foto's kunt animeren om de beveiliging van diverse apps te omzeilen. Deze apps die werken met gezichtsherkenning, vereisen dat je knippert met je ogen of knikt, zo testen ze dat je niet een foto voor de camera houdt. Voor het Westen zijn dit soort ID-diefstal pakketten nog niet aangetroffen, maar het laat wel zien wat de nadelen zijn van een toekomst waarbij je gezicht steeds vaker als wachtwoord dient. Van afschermen biometrische informatie naar concrete misleiding Naast de toenemende mogelijkheden om iemands biometrische kenmerken te klonen, komen er ook steeds meer mogelijkheden biometrische systemen te misleiden. Vorig jaar toonde MacAfee al aan dat je een foto kunt maken die voor de mens op persoon A lijkt en voor een gezichtsherkenningssysteem op persoon B. Een Israelisch bedrijf heeft nu met een andere techniek hetzelfde bereikt. De journalist van dit artikel wordt nu herkend als Mark Zuckerberg. Divers Audio wordt steeds vaker ingezet ter verspreiding van desinformatie. In dit artikel een toelichting over het gebruik door Jordanië van Clubhouse fragmenten. Op dit moment betreft het nog cheapfakes (knip en plakwerk), maar diezelfde, via social media gedeelde audio van mensen kan ook gebruikt worden om de stemmen te klonen. In deze syllabus vind je trouwens een holistische benadering van desinformatie. De rol van (vooral Amerikaanse) historische ontwikkelingen, machtsverhoudingen, cultuur en ongelijkheid wordt meegenomen om het fenomeen te analyseren. Er is een nieuwe versie aangekondigd van DeepFaceLive (bekend van gebruik voor face swapping in pornofilms). Hiermee wordt het mogelijk om ook in livestreams gezichten te vervangen door die van beroemdheden. Bij bewegende deepfake (GAN) beelden zie je vaak dat niet alles even goed mee beweegt, een baard of oorbel wordt niet als gezicht herkend en blijft op dezelfde plek in het beeld terwijl het gezicht beweegt. Onderzoekers hebben daar nu een oplossing voor; alias-free gan . De positieve toepassingen van synthetische media (deepfake technologie) vallen soms een beetje weg in de berichtgeving over de negatieve kant, al eerder berichtte ik over de toepassingen in de medische sector, zoals het klonen van de eigen stem voor mensen met ALS en trauma verwerking. Dit Twitter draadje deelt ook nog mogelijkheden zoals het genereren van ideeën, teksten en video’s ten behoeve van marketing, trainingen en voorlichting. Mogelijkheden die nu voor iedereen toegankelijk zijn zonder specialistische kennis, denk aan ZZPers en het MKB