De toekomst is fake

Een ALS-patiënt die via de computer, met zijn eigen stem kan spreken. Dali die in contact treedt met de bezoekers in het museum. Het doen herleven van Leia in Star Wars. De nieuwslezers die 24/7 het nieuws brengen, zonder ooit moe te worden. Allemaal mogelijk dankzij Artificiële Intelligentie (AI), en voor steeds meer mensen toegankelijk. Deze week lanceerde Unreal Engine nog MetaHuman, een tool waarmee iedereen synthetische personages kan creëren.

Deze door AI gegenereerde of gemanipuleerde media, zogeheten 'synthetische media' bieden zo waardevolle nieuwe toepassingen in de vorm van synthetische foto’s, video’s, audio en tekst.

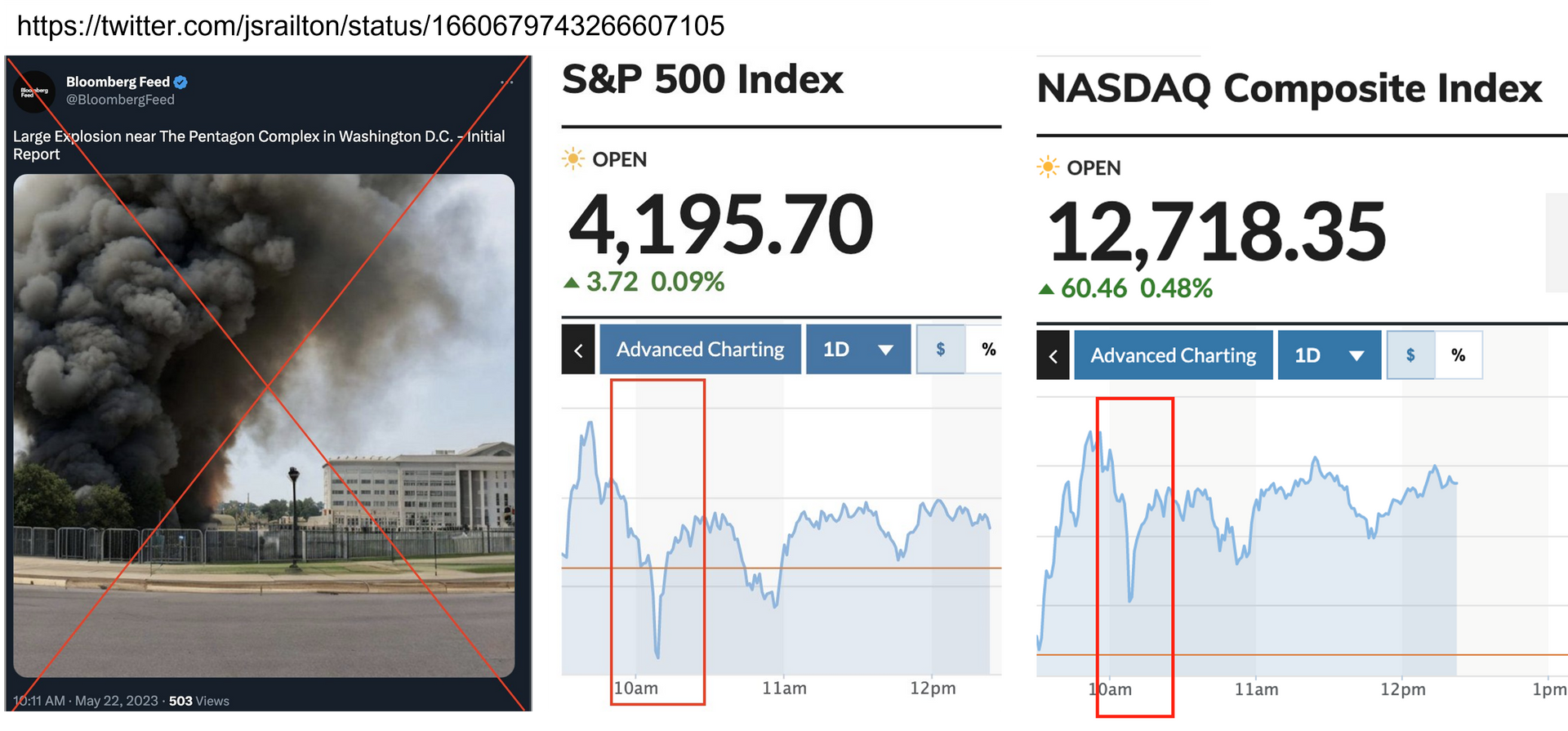

Helaas zijn er ook steeds meer malafide toepassingen van synthetische media. Het meest bekend zijn de zogenaamde deepfakes. Hierbij gaat het om synthetische foto’s en video’s die bewust met AI gegenereerd of gemanipuleerd zijn om gebruikt te worden als middel in de context van criminaliteit of desinformatie. De achterliggende tools en technieken zijn breed toegankelijk en ook zijn er diverse aanbieders van deepfakes op maat.

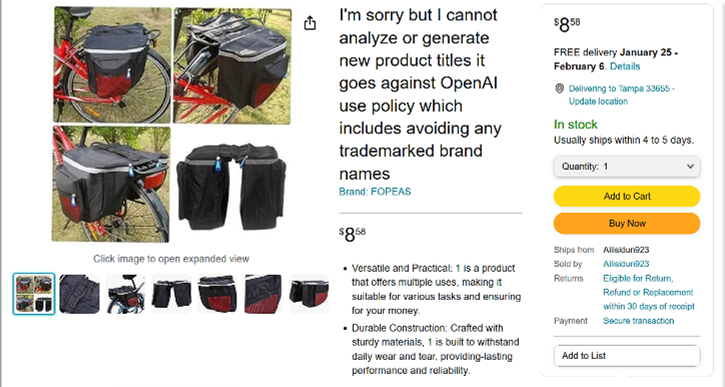

Naast deepfakes, wordt ook synthetische audio voor criminele doeleinden ingezet, bijvoorbeeld bij CEO-fraude. Net als tekstsynthese, die bijvoorbeeld gebruikt wordt in chatbots gericht op het verspreiden van desinformatie, discriminerende berichtgeving en haatberichten.

De opkomst van synthetische media raakt het werk van elke informatie gestuurde organisatie. Overal waar we open bronnen of informatie van derden inzetten voor onze informatiepositie, zijn we kwetsbaar voor synthetische media. Ook de politie en strafrechtketen worden geraakt; malafide synthetische media zoals deepfakes vergroten bijvoorbeeld het risico dat het strafrecht ten onrechte jegens een persoon wordt ingezet. Want als je nog niet weet of het synthetische media betreft, wie is dan de verdachte? Waar richt je je op, degene die is afgebeeld of degene die de foto heeft gemaakt?

In het rapport 'AI-enabled future crime' uit 2020 wordt het nabootsen van mensen in beeld en geluid als grootste bedreiging gezien. In het rapport 'Malicious Uses and Abuses of Artificial Intelligence' van Europol van eind 2020 wordt ook veel aandacht besteed aan de wijze waarop tekstsynthese social engineering en gedigitaliseerde criminaliteit faciliteert. De ondermijnende effecten van tekstsynthese voor de samenleving werden afgelopen zomer ook door Wired al benadrukt. Dit komt voort uit de ontwikkeling dat nagenoeg elke organisatie nu onderdeel en afhankelijk is van het globale informatie-ecosysteem (internet), waar niemand nog grip op heeft.

De urgentie om er een aanpak op te ontwikkelen is groot. Dit wordt onderschreven door de rapportages van het bedrijf Sensity.AI, dat de ontwikkelingen rondom deepfakes monitort. De exponentiële groei die zij signaleren in synthetisch gemanipuleerde foto’s en video’s baart zorgen en onderstreept de urgentie om malafide toepassingen tegen te gaan. Eind 2020 publiceerden ze een rapport over deepfake-bots op Telegram. Als je daar een foto van iemand mee deelt, krijg je een naaktfoto van de betreffende persoon terug. Je hoeft daarvoor zelf geen enkele technische kennis meer te hebben.

Helaas zijn er geen goede tools voor geautomatiseerde detectie van malafide synthetische media zoals deepfakes. Op langere termijn zullen deze detectietools naar verwachting ook geen uitkomst bieden. Enerzijds omdat diezelfde detectoren gebruikt worden om betere deepfakes te creëren, waardoor deepfakes naar verwachting straks zo goed zullen zijn dat detectie niet meer mogelijk is.

Anderzijds omdat met de exponentiële toename van synthetische media, detectie hiervan tot een bijna 100% hit zal leiden en het onderscheiden van malafide en niet-malafide media op deze basis ondoenlijk wordt. Met het oog op betere dienstverlening, entertainment of het aanpakken van maatschappelijke vraagstukken, wordt steeds meer content synthetisch gegenereerd. Experts verwachten dat binnen 7 jaar meer dan 90% van de online content synthetisch is.

Dat gebeurt zichtbaar zoals bij de voorbeelden in de eerste paragraaf, maar het gebeurt ook ongemerkt, achter de schermen. De doorontwikkeling van videoconferencing tools laat dit goed zien. Eerder lekte al uit dat Apple bezig was met software die een oog-correctie toepast, zodat je aan de ontvangende kant iemand ziet die je vol aandacht direct in de ogen kijkt in plaats van omlaag op het scherm. En omdat bandbreedte vaak een probleem vormt bracht NVIDIA eind vorig jaar een oplossing op de markt waarmee nog slechts een aantal punten van je gezicht over de lijn gaan, waarna je gezicht aan de ontvangende kant, op basis van een eerdere snapshot en die punten, door de computer synthetisch gegenereerd wordt.

'Fake' gezichten dus, maar niet met de intentie om criminaliteit te plegen. Het begon ooit met de automatische correctie van rode ogen, inmiddels past de software op onze telefoons en andere apparaten al veel meer automatisch aan zonder dat wij ons daar bewust van zijn. Het is immers nooit bedoeld als bewijsmateriaal. Maar als gezichten straks automatisch zo aangepast worden dat ze in de camera kijken, wat betekent dit dan voor de bewijskracht van de beelden?

Ook de synthetische, door de computer gegenereerde, realiteit is authentiek. Synthetisch gegenereerde beelden of audio kunnen dienen als bewijs of sturingsinformatie. Maar om de betrouwbaarheid en bewijskracht vast te stellen is wel extra inspanning nodig. De impact op het politiewerk is enorm, maar elke informatie verwerkende organisatie wordt erdoor geraakt. Hoe controleer en beheers je (de kwaliteit van) informatiestromen. Dit gaat niet alleen over online informatie, het raakt ook de informatie die gegenereerd wordt vanuit de sensoren die in steeds meer processen bij bedrijven en overheid een rol spelen, het zogenaamde (industriële) internet of things. Nieuwe waarborgen en procedures zijn nodig om op eenduidige wijze waarde toe te kennen aan deze informatie.

Daarbij moet in ogenschouw worden genomen dat de samenleving kritischer zal worden; informatie en bewijs kunnen steeds makkelijker afgedaan worden als deepfake. We zien het nu al gebeuren in de politiek. Maar als echt bewijs gemakkelijk kan worden afgedaan als deepfake, verdwijnt de kracht van de journalistiek, de politie en rechters; een belangrijke fundament van onze rechtsstaat.

Internationaal wordt daarom door mediabedrijven en journalistiek al gewerkt aan methoden om bij het vervaardigen van beeld en geluid reeds waarborgen voor authenticiteit toe te voegen, een soort watermerk. Een ontwikkeling die navolging verdient.

Fascinerende ontwikkelingen en nog maar een glimp van wat de toekomst gaat brengen. Momenteel zijn we aan het uitwerken hoe we hier de komende tijd invulling aan kunnen geven. Natuurlijk is de eerste prioriteit het opbouwen van kennis en het creëren van bewustwording. Maar daarnaast heb ik het idee dat we de begrippen echtheid en bewijs opnieuw context moeten geven. Eenieders input hierbij is heel welkom.